Citation

Les auteurs

Cécile Godé

(cecile.gode@univ-amu.fr) - Aix-Marseille Université CERGAM - ORCID : https://orcid.org/0000-0002-9148-2820Marc Bidan

(marc.bidan@univ-nantes.fr) - Université de Nantesjean-fabrice Lebraty

(jean-fabrice.lebraty@univ-lyon3.fr) - Université Jean Moulin Lyon3, iaelyon, La. Magellan - ORCID : 0000-0001-5175-7052

Copyright

Déclaration d'intérêts

Financements

Aperçu

Contenu

Le procès de ChatGPT

La technologie de traitement naturel du langage, fondée sur le type de réseau de neurones appelé transformers et propulsé sous le nom de ChatGPT par l’entreprise OpenAI, est devenue en quelques mois un sujet d’étude mondial, comme l’illustre la courbe google trend ci-dessous :

Ce succès technologique et médiatique est à l’origine de débats passionnés sur les bienfaits, les défis et les dangers de ce type d’Intelligence Artificielle (IA). C’est justement au regard de cet emballement technologique qu’il convient de confronter les points de vue et c’est ce que nous nous proposons de faire dans cette contribution. Pour rester relativement factuel, nous avons choisi d’aborder ces questions sensibles et complexes sous la forme d’un procès. Nous allons ici restituer le procès imaginaire du robot conversationnel qu’est ChatGPT et qui se trouve être spectaculairement immergé dans le contexte de l’enseignement supérieur et de la recherche. Lors de ce procès, la parole sera successivement donnée au procureur général, qui exposera les éléments à charge contre le robot conversationnel, puis à l’avocate de la défense qui nous proposera sa plaidoirie pour le défendre et enfin au juge qui récapitulera objectivement les arguments entendus en la faveur et en la défaveur du robot et, à l’issue, rendra sa décision finale (coupable, non coupable, etc.) sous forme d’un verdict.

L’accusation : ChatGPT, la grande menace

Monsieur le juge, j’accuse ChatGPT d’être une très grande menace à la fois pour les enseignants-chercheurs et les étudiants. Et j’accuse sans tergiverser et sans nuance car ce robot n’est aucunement inoffensif.

Tout d’abord, il représente la victoire cruelle et définitive de l’artificiel sur l’humain, de la machine sur l’humain. Plus précisément, ce robot introduit dans notre environnement – celui de la recherche et de la formation supérieure – la victoire des « grosses machines énergivores » qu’il préfigure sur les « petits êtres vivants frugaux » que nous sommes. Je l’accuse donc tout simplement – et je pèse mes mots – de mettre en danger la vie et la nature de par l’énormité des ressources énergétiques, électriques et cognitives – notamment les données – dont il aura besoin pour fonctionner, et qu’il va dévorer. Il va vite, il va très vite même – nous sommes déjà en quelques mois à sa version 4 – et dès lors je l’accuse de nous obliger – nous les humains – à devoir à terme… capituler.

Ensuite, non content de nous avoir défait, j’accuse ce robot de vouloir nous soumettre. Il va parvenir à nous soumettre oui… car il est fort et nous sommes faibles. Il est résistant et nous ne le sommes pas. Il est patient et nous ne le sommes plus. La chair et les neurones sont faibles Monsieur le juge ! Le silicium, le tantale, le cobalt et l’acier sont froids Monsieur le juge ! Ce robot et les ordinateurs qui vont le propulser sont pour moi l’image même du triomphe de la paresse intellectuelle au détriment de l’effort, de la complexité, de la subtilité et de la réflexion. Que croyez-vous que nos étudiants – tout comme leurs professeurs – vont bien pouvoir choisir lorsque le choix portera sur une réponse qu’il est possible d’obtenir en quelques secondes ou une autre qui impliquera plusieurs heures de travail (Quinio et Bidan, 2023 ; Bidan, 2023) ? Oui je vois que vous me suivez… bien sûr que nous allons nous soumettre ! Car nous allons aller au plus simple, au plus rapide, au plus facile ! Même si la réponse n’est que vraisemblable, ce n’est pas grave, nous allons bien nous en arranger, nous en contenter … au détriment de la vérité, de la complexité et de la réflexion. La vérité est toujours complexe, douter doit rester l’apanage de l’humain, c’est ce qui le fait progresser. J’accuse donc ChatGPT de nous conduire – nous les humains – vers la soumission !

Pour finir Monsieur le juge, j’accuse le transformer de mettre en danger la relation entre l’enseignant et l’enseigné, car les deux finiront par se satisfaire de la vraisemblance du contenu qui leur sera servi. Ils vont cesser leurs efforts et leur difficile – mais si indispensable – cheminement cognitif vers la vérité, la pensée, la morale, l’éthique. J’accuse ChatGPT de mettre en danger la connaissance, et plus exactement le statut de la connaissance au profit d’une vague vraisemblance qui peu à peu va tout emporter… Nous allons vers un monde de l’à peu près et de l’approximatif – un monde d’hallucination selon les propres dires du transformer – alors que nous quittons un monde de beauté complexe et de sage connaissance ! Je l’accuse de ruiner ce que l’homme – qu’il soit étudiant ou enseignant peu importe finalement – a de plus beau et qui fait son humanité : sa pensée.

La défense : ChatGPT, un partenaire pour apprendre

Le parquet joue son rôle lorsqu’il expose sa requête à l’exclusive charge de mon client, ChatGPT. Si je retiens ses principaux arguments, il est coupable de rendre nos étudiants paresseux, plagiaires et bien incapables au final. Voici une posture d’adversaire vis-à-vis du transformer qui ne surprend pas et semble alignée à la méfiance – bien compréhensible – dont fait largement preuve l’enseignement supérieur aujourd’hui. La preuve en est de l’interdiction pure et simple de ChatGPT dans de nombreuses institutions à travers le monde : blocage sur les réseaux et postes informatiques éducatifs de New-York City et Seattle (partiellement), interdiction pure et simple de la part du réseau Sciences Po sous peine d’exclusion de ses étudiants, etc. Force est cependant de constater que ces interdictions sont sans effet probant, les contournements étant particulièrement aisés, en passant par exemple par le téléchargement d’un VPN ou en utilisant Bing, qui intègre ChatGPT, pour ses recherches. On observe aussi un engouement pour des logiciels détecteurs de contenu. GPT Zero, Draft & Goal et autres sont intéressants mais restent très faciles à tromper (en demandant par exemple à un autre robot de paraphraser le contenu obtenu) et peuvent renforcer le désir des étudiants d’utiliser le transformer en évitant les garde-fous. Alors oui, la transformation des processus d’apprentissage, de recherche (Dwivedi et al., 2023), voire décisionnel et de coordination (Godé, 2008) seront d’envergure avec cette IA générative. Mais ces postures d’adversaire vis-à-vis de ChatGPT ne sont-elles pas contre-productives tant le déséquilibre des forces en présence est majeur ? Sans adopter une approche candide, n’est-il pas envisageable de coopérer au bénéfice de nos étudiants, plus que de s’opposer ?

En tant qu’avocate de la défense, c’est l’approche que je privilégie : je vais vous montrer que ChatGPT peut être un partenaire de l’enseignant-chercheur et des étudiants dans leurs démarches pédagogiques et d’apprentissage. La littérature offre un spectre de plus en plus large d’exercices à réaliser (par exemple, Erasmus & European Union, 2020 ; Mollick et Mollick, 2022). En voici deux, visant des objectifs distincts, adaptés à la fois au niveau des étudiants (en l’occurrence, une cohorte d’étudiants en Licence 3) et aux capacités grandissantes du transformer.

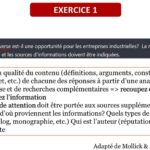

Le premier exercice se fonde sur la question suivante : comment ChatGPT peut-il aider nos étudiants à penser de manière critique, à douter, à analyser et interroger ce qui peut/veut s’imposer comme vrai ? Nous l’avons tous constaté, le transformer produit des contenus faux ou approximatifs avec beaucoup d’aplomb et d’assurance stylistique. Il s’agit alors d’exploiter ce défaut pour développer une compétence (encore) proprement humaine : l’esprit critique. Comme l’expose la figure 1, le prompt est donné aux étudiants, tout comme des liens vers des méthodes de vérification et fiabilisation des sources (produites par un réseau de bibliothèques universitaires).

Cet exercice est proposé aux étudiants pour cerner les arguments pour/contre et comprendre la « contextualisation » de l’information créée par ChatGPT. Très vite après l’effet « waouh ! », les étudiants vont porter un regard critique et plus posé en apprenant à faire des recherches et à vérifier les sources (pour la plupart introuvables) du contenu généré. Cela va les conduire à recouper les informations pour discerner l’information de la désinformation, à identifier les incohérences, à confronter les arguments, à critiquer la structure cause-conséquence, recherchant les sources proposées, etc.

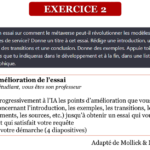

Le second exercice représente une opportunité pour apprendre aux étudiants à travailler avec des transformers, qui feront largement partie de leur environnement de travail futur (PwC, 2022). Il s’agit d’éprouver leurs capacités à apprendre aux robots à répondre précisément à leurs demandes, à partir de requêtes précises, afin de satisfaire leurs besoins au plus près. Là encore, le prompt est donné aux étudiants.

Les étudiants sont les professeurs de ChatGPT. Ils apprennent à lui demander davantage d’approfondissements, d’arguments, d’illustrations, etc. Ils réclament les sources du contenu généré, pointent les incohérences et lui demandent de « revenir sur sa copie ». En bref, les étudiants apprennent à collaborer avec le transformer dans une démarche de confrontation à des questions et idées dont ils n’ont pas encore de réponses et connaissances précises.

Le verdict

Rappelons tout d’abord les conditions de ce procès. L’accusation a été lancée en janvier 2023 et a concerné ChatGPT 3.5. Force est de constater qu’au moment où j’énonce ce verdict, cette version a été remplacée par la 4, et que la version 5 s’esquisse, a priori attendue pour la fin de l’année. Ensuite, ChatGPT se fonde sur une technologie élaborée par des humains (Sancheng et al., 2022). L’outil en lui-même n’a pas d’intentionnalité qui lui est propre, tout du moins à ce niveau d’apprentissage. Certes, des patterns peuvent émerger, et ceci constitue le troisième argument, lié au contenu. Car, enfin, ce contenu qui lui sert de base provient de documents produits indistinctement par des humains et – même si à la marge actuellement – par d’autres générateurs de texte. Ainsi, s’il y a une intentionnalité émergente, elle provient de l’intentionnalité des documents, mais également de la sélection de ces documents servant son apprentissage.

Pour ces trois principales raisons, ChatGPT 3.5 est considéré comme irresponsable et, à cet effet, ne peut être jugé. En revanche, deux grandes recommandations peuvent être énoncées.

Concernant les concepteurs de ce type de technologie, il est essentiel que les règles de modération et d’orientation des réponses soient clairement exprimées et donc consultables. Ceci afin de contourner le piège du vrai versus vraisemblable.

Concernant les établissements d’enseignement supérieur, trois injonctions peuvent être appliquées. Premièrement, il apparait essentiel de dispenser à tous les niveaux (de la Licence 1 au Master 2) des cours abordant l’IA. Il s’agira d’une part de démystifier le concept d’IA et, d’autre part, d’être apte à travailler avec une IA. Ainsi, de mon point de vue, quatre langues sont nécessaires à nos étudiants : le français, l’anglais, les mathématiques et du code. Chaque étudiant doit avoir au moins des notions dans les quatre langues et être avancé dans au moins deux langues sur ces quatre. Les enseignements en et sur l’IA devront combiner les quatre langues, notamment pour apprendre à construire des prompts et formuler des requêtes efficaces à ChatGPT et ses variantes.

Deuxièmement, à l’instar des revues académiques, il est urgent de mettre en place un abonnement de type Couperin pour que les étudiants et les universitaires aient un accès professionnel complet à l’API (Application Programming Interface) de ChatGPT et des autres IA de cette catégorie. Ainsi, non seulement les limites des versions gratuites seront levées, mais les étudiants et universitaires développeront également des compétences dans l’utilisation d’une API.

Enfin, il m’apparait primordial de générer des moyens pour collecter des données issues des enseignements dispensés par les universitaires français et francophones. En effet, il y a ici un gisement d’excellente qualité qui risque de devenir invisible aux yeux d’étudiants qui n’utiliseraient que des réponses provenant d’autres sources. L’objectif est donc de participer à la création d’une IA francophone et souveraine, destinée à l’enseignement supérieur.

Ces recommandations clôturent ainsi le procès de ChatGPT, mais un appel reste possible et ce n’est certainement pas la fin de l’histoire !

Bibliographie

Références

Bidan, M. (2023). Quel avenir pour les producteurs de contenus ? Une conversation avec… ChatGPT ! The Conversation, 19 janvier. https://theconversation.com/quel-avenir-pour-les-producteurs-de-contenus-une-conversation-avec-chatgpt-194111

Dwivedi, Y. K. et al. (2023). “So what if ChatGPT wrote it?” Multidisciplinary perspectives on opportunities, challenges and implications of generative conversational AI for research, practice and policy. International Journal of Information Management, 71, 102642. Doi: 10.1016/j.ijinfomgt.2023.102642.

Erasmus & European Union (2020). CHAT2LEARN: Chatbot technologies for digital entrepreneurship education and adult learners. Methodology How to incorporate chatbot technologies into educational process, Project n°2020-1-CY01-KA204-065974. https://chat2learn.eu/wp-content/themes/chat2learn/assets/docs/methodology/methodology-en_GB.pdf

Godé, C. (2008). Les TIC comme leviers du changement organisationnel : une analyse du cas des Armées américaines en Afghanistan. Systèmes d’information & management, 13(1), 7-30. Doi: 10.3917/sim.081.0007

Quinio, B. et Bidan M. (2023). ChatGPT : un robot conversationnel peut-il enseigner ? Management et Datascience, 7(1). Doi : 10.36863/mds.a.22060

Mollick, E.R. et Mollick, L. (2022). New modes of learning enabled by AI chatbots: Three methods and assignments. SSRN: https://ssrn.com/abstract=4300783. Doi: 10.2139/ssrn.4300783

PwC (2022). AI business survey. https://www.pwc.com/us/en/tech-effect/ai-analytics/ai-business-survey.html

Sancheng, P., Lihong C., Yongmei Z., Zhouhao O., Aimin Y., Xinguang L., Weijia J. et Shui Y. (2022). A survey on deep learning for textual emotion analysis in social networks. Digital Communications and Networks, 8(5), 745-762. Doi : 10.1016/j.dcan.2021.10.003.