Citation

L'auteur

Robert VISEUR

(robert.viseur@umons.ac.be) - Université de MONS - ORCID : 0000-0003-4385-4332

Copyright

Déclaration d'intérêts

Financements

Aperçu

Contenu

Le secteur de l’e-commerce en Europe connaît une croissance notable depuis de nombreuses années. Sur le plan de la valeur marchande, il dépassait ainsi les 500 milliards de dollars en 2021, après avoir été dopé par les mois de crise de la COVID-19 (Jílková & Králová, 2021). L’adoption progresse également parmi les citoyens de l’UE. Les trois quarts des internautes y ont ainsi effectué des achats en ligne en 2022 (source : Eurostat). Les opportunités alléchantes du commerce électronique masquent néanmoins les défis considérables auxquels sont confrontés les entrepreneurs, englobant l’élaboration de la stratégie commerciale, la conception du site e-commerce, la structuration de l’offre, la gestion de la relation client, ainsi que la mise en place de la chaîne logistique (Isaac & Volle, 2008). Face à ces contraintes, des approches alternatives ont été conçues. Parmi celles-ci, le dropshipping se démarque en offrant la possibilité de transférer la responsabilité logistique au fournisseur de manière transparente pour le client (Kouja, 2001). Cette stratégie a rapidement suscité l’espoir d’une prospérité accélérée, bien que le dropshipper reste tenu à certaines obligations, notamment en matière de service après-vente, qui peuvent parfois engendrer des déconvenues (Leloup, 2019). Dans le spectre des modalités de dropshipping autorisant un démarrage rapide de l’activité, une approche demeure relativement peu explorée dans la littérature académique : le « dropshipping SEO ».

Un ecommerce light : le « dropshipping SEO »

Le dropshipping SEO consiste à identifier une niche de clientèle rentable puis de positionner un site web proposant des articles en dropshipping. Le choix d’une niche étroite se prête à des pratiques de SEO (Search Engine Optimization) exploitant une longue traîne de mots-clefs (Anderson, 2007). L’énergie du dropshipper se concentre donc sur sa capacité à créer un contenu soigneusement optimisé pour son site web. Outre la maîtrise des techniques SEO, l’entrepreneur doit donc encore proposer un contenu qualitatif. Le potentiel des intelligences articifielles (IA) génératives telles que ChatGPT n’a dès lors pas échappé au secteur, dont une frange particulièrement réactive et opportuniste a entrepris la création massive et automatisée de site de dropshipping par la transformation de contenus pré-existants, extraits de sites ecommerce tiers performants, ou par la génération de contenus originaux. Ces pratiques de scraping, de transformation, de génération et d’optimisation du contenu de sites e-commerce pour créer de nouveaux sites ciblant des niches, notamment linguistiques, spécifiques soulève des questions éthiques, que nous traiterons sous l’angle de l’éthique utilitariste et de l’éthique déontologique (Nantel & Weeks, 1996). Dans quelle mesure ces activités, bien que profitables pour certains développeurs, pourraient-elles nuire à la loyauté de la concurrence et à la protection du consommateur dans le secteur du commerce électronique ?

Une combinaison du SEO et des IA génératives

Le dropshipping consiste, pour le gestionnaire d’un site e-commerce, à simplement « transmet(tre) les commandes de ses clients au fabricant, qui exécute les commandes directement auprès des clients et se fait payer un prix prédéterminé par le détaillant » (Khouja, 2001). Le « dropshipping SEO » l’associe au SEO (Search Engine Optimization), soit un ensemble de techniques permettant d’améliorer le positionnement des pages du site dans les résultats naturels du moteur de recherche. Deux types de SEO sont mobilisées pour cela : le SEO « on page » et le SEO « off page » (Shahzad et al., 2020). Le premier inclut la sélection des mots-clefs sur lesquels les pages vont être optimisées, la création du contenu et l’insertion des mots-clefs au sein de la structure de balises du document HTML. Le second inclut la stratégie de construction de « backlinks », c’est-à-dire d’hyperliens pointant vers les pages du site depuis des sites tiers.

Au cours des dix dernières années, les applications basées sur l’intelligence artificielle ont sensiblement évolué. C’est notamment le cas des applications basées sur les réseaux de neurones profonds (deep learning). Parmi les technologies désormais incontournables les Large Language Models (LLM) ont gagné en visibilité avec le modèle GPT-3, utilisé notamment par OpenAI pour son agent conversationnel ChatGPT. GPT-3 (Generative Pre-trained Transformer) est un modèle de langue autorégressif de troisième génération qui utilise l’apprentissage profond pour produire des textes d’apparence humaine (Floridi & Chiriatti, 2020). Cette technologie s’est distinguée par ses capacités, d’une part, à interpréter une consigne exprimée en langage naturel (ou prompt), d’autre part, à réaliser une large variété de tâches : production d’un texte en langage naturel ou en code informatique (format de données, programmation…), correction d’un texte (orthographe, grammaire…), transformation d’un texte (résumé, re-structuration, reformulation, paraphrasage…), traduction d’un texte… Ces nouvelles potentialités n’ont pas manqué d’éveiller la curiosité de référenceurs adeptes des techniques abusives.

Une méthodologie hybride

L’exploration des pratiques de dropshipping SEO assistée par l’IA générative s’est articulée autour de trois instruments méthodologiques complémentaires. Initialement, nous avons emprunté les principes de la netnographie (Kozinets, 2002), ce qui nous a conduit à observer, notamment sur Twitter (X), les échanges au sein d’une communauté gravitant autour d’un dropshipper SEO reconnu, opérant sous le pseudonyme de David BlackHat. Ce dernier rassemble une communauté d’apprenants ainsi que de jeunes référenceurs. Notre choix s’est porté sur cette figure en raison de sa notoriété sur cette plateforme sociale, complétée par sa présence active sur divers réseaux et médias sociaux (Twitter, Youtube…), où il promeut des techniques particulièrement agressives, souvent dévoilées au travers de formations payantes. Ces stratégies séduisent par l’anticipation de gains substantiels et immédiats, reposant sur la mise en place d’une multitude de sites web monétisés via la publicité et le dropshipping. L’analyse des échanges au sein de cette communauté a essentiellement ciblé les méthodes et outils promus pour le référencement et la valorisation des sites web. En second lieu, nous avons procédé à l’écoute active de vidéos dans lesquelles cet expert en dropshipping SEO détaillait son itinéraire et ses méthodes. En dernier lieu, nous avons collecté un échantillon de tweets depuis le compte de cet influenceur, avant de générer deux nuages de mots facilitant l’identification des thèmes centraux de sa communication. Ces nuages illustrent, d’une part, des expressions courantes (thèmes récurrents), et d’autre part, des entités nommées fréquentes (partenaires, outils…). Leur élaboration a été conduite avec le langage de programmation Python et a recouru au traitement automatique du langage naturel (Viseur, 2014).

Une stratégie basée sur création massive de sites

Les pratiques de dropshipping SEO assistées par IA génératives ont été étudiées au travers d’une communauté centrée sur un spécialiste du domaine, revendiquant plusieurs milliers de sites web. En vertu du principe que « les petits ruisseaux forment les grandes rivières », plusieurs centaines, voire plusieurs milliers, de sites rapportant peu individuellement généreraient globalement des revenus élevés. La rentabilité dépendrait donc de la capacité à multiplier les sites pour un coût minimal. La stratégie de « copier, reformuler, traduire » (revendiquée comme de la « piraterie » par son promoteur) s’appuie sur des outils d’extraction, de transformation et de traduction de textes (cf. Tableau 1). Après avoir identifié une niche thématique porteuse, le contenu est démultiplié sur un grand nombre de langues, en particulier pour des zones linguistiques où la concurrence est plus faible.

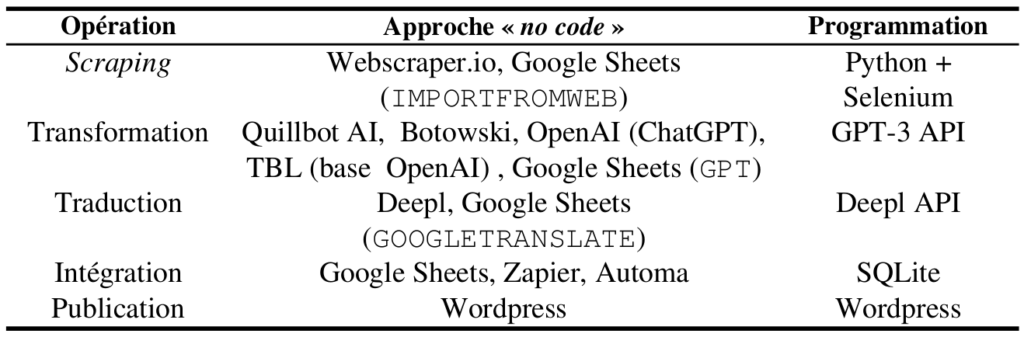

Table 1. Outils exploitables dans la chaîne de copie automatisée.

La première étape consiste à se procurer du contenu référençable. Les approches classiques consistant à internaliser la rédaction ou à l’externaliser sur des plates-formes idoines (p. ex. Fiverr), permettant d’abaisser sensiblement les coûts, sont ici généralement délaissées au profit, d’une part, de techniques de collecte par scraping, soit sur la Wayback Machine (récupération du contenu de sites disparus), soit de sites toujours actifs (par exemple au départ du sitemap.xml du site), et d’autre part, de la génération par intelligence artificielle. Pour ce qui est du scraping, en fonction de l’expertise, des approches « no code » ou par programmation sont possibles. La seconde étape consiste à transformer le texte collecté avec des outils permettant au minimum la reformulation ou le paraphrasage, puis enfin, à le traduire. Dans l’approche « no code », l’intégration des différents outils est réalisée à l’aide des outils Zapier, Automa ou directement avec Google Sheets. En effet, de nombreux outils s’intègrent directement à ce tableur en ligne. De plus, il permet également de réaliser certaines de ces opérations en interne, avec des fonctions prédéfinies (p. ex. GOOGLETRANSLATE pour la traduction) ou des fonctions installées via la Marketplace (p. ex. IMPORTFROMWEB pour le scraping ou GPT pour le prompt). Pour ce qui est de la génération par IA, la technique consiste, soit à rédiger un ensemble d’articles, puis à les démultiplier à l’aide d’un prompt dans ChatGPT (reformulation), soit à générer un contenu « original » pour chacun des sujets générés à l’aide d’un prompt dans ChatGPT. Des outils orientés SEO, basés sur OpenAI, émergent également (p. ex. TBL Generator). La troisième étape consiste à sauvegarder les articles finalisés au sein d’un ou de plusieurs blogs sous WordPress (ou n’importe quel autre CMS : Content Management System). Cette chaîne de traitement permet donc de générer à moindres frais un très grand nombre de sites fortement thématisés, utilisés, soit pour de l’affichage de publicités, soit pour la vente en dropshipping, soit pour renforcer un site principal dédié à la vente en ligne.

Des enjeux éthiques et pratiques multiples

L’éthique, dans le cadre du marketing, renvoie à un ensemble de principes et de normes morales encadrant les pratiques commerciales et publicitaires. Nous nous appuierons sur les travaux de Nantel et Weeks (1996), qui distinguent deux orientations de l’éthique en marketing. La première, d’orientation utilitariste, est plus ancienne et met l’accent sur la satisfaction du client. La seconde, plus récente, s’inscrit dans une perspective déontologique. Ainsi, sont valorisés, notamment au travers de codes d’éthique, le respect scrupuleux des législations tant dans leur esprit que dans leur lettre, une présentation transparente des caractéristiques des produits proposés, ainsi que l’exclusion de toute pratique de vente et de publicité tendancieuse ou trompeuse. L’emploi des outils d’IA générative, et plus globalement de l’ensemble des outils énumérés dans le Tableau 1, peut induire des pratiques distinctes sur le plan éthique.

En matière de référencement, les IA génératives permettent par exemple l’extraction des points forts et des points faibles d’un ensemble de produits, sur base de pages de commentaires. Cela permet de proposer des argumentaires commerciaux, à la fois qualitatifs pour le client et optimisés pour le référencement. L’IA générative apparaît ici comme une aide supplémentaire à la rédaction susceptible d’améliorer la qualité des contenus publiés en ligne et indexés par les moteurs de recherche. L’éthique utilitariste est dès lors respectée. Reste que certains sites contestent l’éthique déontologique de type d’usage dès lors que leur contenu sert aussi à entraîner les modèles utilisés par OpenAI sans réelle négociation préalable. La place de marché Amazon bloque ainsi le GPTBot, le robot d’exploration d’OpenAI, depuis son fichier robots.txt.

Le dropshipping SEO assisté par IA générative pose un ensemble autrement plus vaste de problèmes éthiques. Il s’appuie en effet sur des plates-formes outillées permettant de reformuler, massivement et automatiquement, des contenus préalablement « pillés ». L’objectif est dès lors, après une phase de SEO « off-page » et « on-page » (portant notamment sur la structuration du site, les images et les choix de mots-clefs), visant parfois à tromper le moteur quant au contenu réel des pages (au prix d’une dégradation maîtrisée du taux de rebond), de générer plusieurs centaines de sites et de les indexer dans les moteurs de recherche (Google, Bing…). Cette pratique transgresse manifestement tant les principes d’éthique utilitariste, en orientant les clients vers des contenus conçus pour la maximisation des revenus sans véritable engagement envers la clientèle, qu’envers l’éthique déontologique.

En premier lieu, elle viole la reconnaissance de la paternité des œuvres (droit d’auteur), en l’occurrence le contenu des pages web aspirées et modifiées sans autorisation. La preuve de la contrefaçon (ou de concurrence déloyale sous forme de parasitisme) est par ailleurs d’autant plus difficile à établir que le contenu est fortement transformé. En second lieu, elle intensifie la concurrence de façon inéquitable envers les compétiteurs davantage préoccupés par l’intérêt des consommateurs. En troisième lieu, son apparente facilité, et la minimisation des responsabilités par ses promoteurs, la rend attractive malgré les risques légaux (droits d’auteur, concurrence déloyale, protection du consommateur…). En quatrième lieu, elle expose les moteurs de recherche à une dégradation graduelle de la qualité des résultats naturels, en raison de la saturation de leurs index par des contenus générés automatiquement. Ces démarches soulèvent des problématiques relatives à la détection des contenus générés et à la réaction adéquate face à ces pratiques. De nombreuses études se concentrent actuellement sur l’élaboration d’outils capables de détecter les textes produits par des IA génératives telles que ChatGPT. Elles concluent souvent à leur faible efficacité (Pegoraro et al., 2023), en particulier pour les textes produits avec des versions plus récentes du modèle sous-jacent à ChatGPT (Walters, 2023).

Bibliographie

Anderson, C. (2012). La longue traîne. Pearson. ISBN : 978-2744062698.

Floridi, L., & Chiriatti, M. (2020). GPT-3: Its nature, scope, limits, and consequences. Minds and Machines, 30, 681-694. https://doi.org/10.1007/s11023-020-09548-1.

Isaac, H., & Volle., P. (2008).E-commerce De la stratégie à la mise en œuvre opérationnelle. Pearson. ISBN : 978-2744074486.

Jílková, P., & Králová, P. (2021). Digital consumer behaviour and ecommerce trends during the COVID-19 crisis. International Advances in Economic Research, 27(1), 83-85. https://doi.org/10.1007/s11294-021-09817-4.

Khouja, M. (2001). The evaluation of drop shipping option for e-commerce retailers. Computers & Industrial Engineering, 41(2), 109-126. https://doi.org/10.1016/S0360-8352(01)00046-8.

Kozinets, R. V. (2002). The field behind the screen: Using netnography for marketing research in online communities. Journal of marketing research, 39(1), 61-72. https://doi.org/10.1509/jmkr.39.1.61.18935.

Leloup, D. (2019). Devenir riche sur Internet sans rien faire : les mirages du « dropshipping ». Le Monde. 31 juillet 2019. https://www.lemonde.fr/pixels/article/2019/07/31/devenir-riche-sans-rien-faire-les-mirages-du-dropshipping-sur-internet_5495194_4408996.html.

Nantel, J., & Weeks, W. A. (1996). Marketing ethics: is there more to it than the utilitarian approach?. European journal of marketing, 30(5), 9-19. https://doi.org/10.1108/03090569610118713.

Pegoraro, A., Kumari, K., Fereidooni, H., & Sadeghi, A. R. (2023). To ChatGPT, or not to ChatGPT: That is the question!. arXiv preprint. https://doi.org/10.48550/arXiv.2304.01487.

Shahzad, A., Jacob, D. W., Nawi, N. M., Mahdin, H., & Saputri, M. E. (2020). The new trend for search engine optimization, tools and techniques. Indonesian Journal of Electrical Engineering and Computer Science, 18(3), 1568-1583. http://doi.org/10.11591/ijeecs.v18.i3.pp1568-1583.

Viseur, R. (2014). Automating the Shaping of Metadata Extracted from a Company Website with Open Source Tools. International Journal of Advanced Computer Science and Applications (IJACSA), Special Issue on Natural Language Processing, 2014, 31-35. https://dx.doi.org/10.14569/SpecialIssue.2014.040105.

Walters, W. H. (2023). The effectiveness of software designed to detect AI-generated writing: A comparison of 16 AI text detectors. Open Information Science, 7(1), 20220158. https://doi.org/10.1515/opis-2022-0158.