Citation

Les auteurs

Magalie Duarte

(magalie.duarte@bsb-education.com) - Burgundy School of BusinessGuillaume Biot-Paquerot

- Burgundy Shool of BusinessMarc Bidan

(marc.bidan@univ-nantes.fr) - Université de Nantes

Copyright

Déclaration d'intérêts

Financements

Aperçu

Contenu

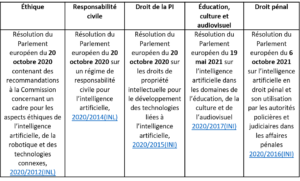

Dans le même esprit que les quatre années de travaux qui ont mené au règlement général sur la protection des données personnelles (RGPD), la Commission européenne innove, une fois encore, dans sa manière de poser un cadre de travail normatif harmonisé [1] concernant l’intelligence artificielle. Elle aborde ainsi la question de façon globale et ambitieuse, de concert avec les recommandations du Parlement européen et du Conseil.

Tableau 1 : Cinq résolutions européennes récentes sur l’IA

L’objectif est double. D’une part, il convient de promouvoir les opportunités inédites liées aux technologies de l’information. D’autre part, il s’agit d’en prévenir les risques, défis et impacts. À titre de comparaison, le RGPD en 2018 visait à envoyer un message fort aux citoyens quant à leurs droits face à la responsabilité de ceux qui traitent leurs données personnelles, comme la condition, pour les entreprises, pour tirer parti « au mieux » des opportunités technologiques fondées sur ces données[1]. Il en va de même concernant ce nouveau projet de règlement nommé « Artificial Intelligence Act » (AIA)[2]qui fut publié le 21 avril 2021 et qui est appliqué aux produits et services embarquant des « systèmes d’intelligence artificielle ». L’Union Européenne fixe le cap : elle ambitionne d’être « un acteur mondial de premier plan dans le développement d’une intelligence artificielle sûre, fiable et éthique »[3]. Il s’agit là d’un outil emblématique pour dérouler la stratégie européenne pour « la décennie numérique » (dite d’ailleurs « boussole numérique ») en cours[4], en lien directe avec le cadre règlementaire sur la gouvernance des données[5] et l’ouverture des données[6] (Open Data). Alors, dans quelle mesure l’AIA permet-il de combler le manque de « cartes » déploré par les managers, pour une navigation dans le terrain opportun mais incertain de l’IA (Kaplan & Haenlein, 2020 ; Kolbjørnsrud et al., 2017) ? Fort de ce contexte à la fois opérationnel et stratégique, ce texte nous oblige à sortir ici de l’exercice législatif traditionnel pour observer le rôle du régulateur dans l’évolution des « standards » du management des systèmes d’information (Kalle L., King J. L., 2006) et, en particulier, dans la gestion des risques en informatique (Laurent M., Khatchatourov A., 2018). En effet, le pari est d’installer une vision plus managériale, en termes de management de la qualité et de la conformité (articles 17, 19 et 43), de gestion des risques (article 9) et de gouvernance des données (article 10).

Une fusée européenne à plusieurs étages, de l’interdiction aux bonnes pratiques

La première étape de ce projet de règlement n’est pas anecdotique, il faut tout d’abord définir l’IA. La définition proposée apparaît donc volontairement large. L’IA est abordée comme « un logiciel qui est développé au moyen d’une ou plusieurs des techniques et approches énumérées à l’annexe I et qui peut, pour un ensemble donné d’objectifs définis par l’homme, générer des résultats tels que des contenus, des prédictions, des recommandations ou des décisions influençant les environnements avec lesquels il interagit » (article 3). Cette définition se focalise sur le système en tant que tel et non uniquement sur la « machine ». Cette dernière dispose d’ailleurs de sa propre proposition de règlement visant à mettre à jour la directive « machines » de 2006[7]. Ainsi, sur le territoire de l’UE, lorsqu’on met sur le marché un système permettant d’établir automatiquement un profil d’utilisateur (cf. à ce propos, l’article 4 du RGPD sur le profilage[8]), d’émettre une décision individuelle entièrement automatisée (article 22 du RGPD), ou encore de générer automatiquement du contenu (vocal, textuel, recommandations, etc.) …, on pratique de l’IA ! Cela ne se réduit pas aux techniques auto-apprenantes (ou machine learning), mais inclut celles s’appuyant sur la logique et les connaissances (IA symbolique) ou encore sur les statistiques[9]. Le RGPD nous avait déjà appris que la pratique entraîne la responsabilité du traitement des données personnelles et la nécessaire transparence vis-à-vis des personnes concernées (droit des personnes). L’AIA reprend en partie ces dimensions mais il y ajoute un cadre de bonnes pratiques managériales associées pour « mettre [ces IA] sur le marché » (réglementation des produits et des services).

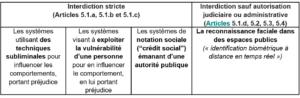

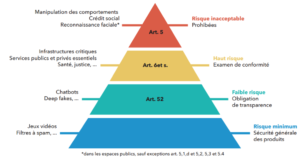

Au sujet des bonnes pratiques, nous notons d’abord un certain nombre de systèmes tout simplement interdits (article 5) que la Commission considère comme liberticides.

Tableau 2 : Quatre systèmes interdits mobilisant l’IA (article 5)

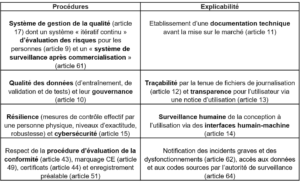

Ensuite, nous abordons les systèmes autorisés. Ceux-ci sont classés par niveau de risque par rapport à « la santé et la sécurité, ou un risque d’incidence négative sur les droits fondamentaux ». Les exigences les plus détaillées concernent les systèmes d’IA à « haut risque ». On considère un système comme tel soit parce qu’il est un composant touchant à la sécurité de produits déjà soumis à une évaluation de conformité par un tiers (article 6.1 et annexe II ; sécurité des jouets, des ascenseurs ou encore des dispositifs médicaux), soit parce qu’il figure dans la liste proposée en annexe III (article 6.2). Cette dernière est très étoffée bien que qualifiée de non exhaustive et non figée. Nous y retrouvons les autres usages de la reconnaissance faciale, l’utilisation de l’IA par les autorités répressives, pour l’accès à l’éducation, à l’emploi, ainsi qu’aux services publics ou privés dits « essentiels ». Pour ces systèmes à « haut risque », il faut démontrer la conformité (compliance) en amont, prévoir les moyens en permettant le contrôle et poursuivre la surveillance, au-delà de la mise sur le marché, tout au long du cycle de vie du système.

Tableau 3 : Exigences de procédures et d’explicabilité pour les systèmes d’IA à haut risque

Finalement, l’accent est également mis sur l’explicabilité de ces systèmes d’IA à haut risque, en particulier sur le rôle de l’humain de sa conception jusqu’aux contrôles continus de son utilisation (article 14), un focus clé dans la recherche en management appliquée à la relation humain-IA (Makarius, Mukherjee, Fox et Fox, 2020).

Celui sur qui pèsent ces risques et ces exigences est le fournisseur : « qui développe ou fait développer un système d’IA en vue de le mettre sur le marché ou de le mettre en service sous son propre nom ou sa propre marque, à titre onéreux ou gratuit » (article 3). Notons que tout autre opérateur (utilisateur, importateur ou distributeur) qui met une IA sur le marché sous son propre nom ou en modifie la destination initiale ou encore qui modifie substantiellement son fonctionnement, peut également être requalifié de « fournisseur » (article 28). Les sanctions en cas de non-conformité peuvent être lourdes : par exemple, jusque 30 millions d’euros ou 6% du chiffre d’affaires mondial annuel total en ce qui concerne les interdictions de l’article 5 ou les exigences de l’article 10 (sur les données) précités.

Il faut savoir enfin que certains systèmes, à risque faible (article 52), sont essentiellement soumis à l’obligation de transparence (deepfake, chatbots, et autres robots s’appuyant sur la reconnaissance émotionnelle pour interagir, etc.) ce qui n’est déjà pas négligeable ! D’ailleurs, ils ne sont pas moins concernés par l’éthique (Devillers, 2019), en l’absence d’examen de conformité obligatoire, la mise en place de « codes de conduite » est ainsi fortement recommandée (article 69), notamment pour la prise en compte de l’impact social et environnemental de ces systèmes. La Commission européenne a donc publié en 2021 un texte qui – dans la logique du RGPD – a pour vocation et objectif de règlementer la pratique et le déploiement de l’intelligence artificielle en Europe. Elle consacre ainsi l’entrée de l’IA dans l’organisation. La seconde partie de cet article consacré à l’AIA abordera les impacts systémiques et les implications managériales d’un tel document, notamment sur l’action publique.

Figure 1 : Synthèse de la classification des risques des systèmes d’IA (Meneceur, 2021)

[1] Commission européenne, « Livre blanc. Intelligence artificielle, une approche européenne axée sur l’excellence et la confiance», COM (2020) 65 final, 2020.

[2] Commission européenne, « Proposition de règlement du Parlement européen et du Conseil établissant des règles harmonisées concernant l’intelligence artificielle (législation sur l’intelligence artificielle) et modifiant certains actes législatifs de l’Union, dit « Artificial Intelligence Act » », COM (2021) 206, 21 avril 2021.

[3] Idem

[4] Commission européenne, « Communication de la Commission au Parlement européen, au Conseil, au Comité économique et Social européen et au Comité des Régions. Une boussole numérique pour 2030 : l’Europe balise la décennie numérique », COM (2021) 118 final, mars 2021.

[5] Proposition de règlement du Parlement européen et du Conseil sur la gouvernance européenne des données (acte sur la gouvernance des données), COM (2020) 767 final, novembre 2020.

[6] Directive (UE) 2019/1024 du Parlement européen et du Conseil du 20 juin 2019 concernant les données ouvertes et la réutilisation des informations du secteur public (PE/28/2019/REV/1), dite « Directive Open Data ».

[7] Commission européenne, « Proposition de règlement du Parlement européen et du Conseil sur les machines et produits connexes », Bruxelles, COM (2021) 202 final, le 21 avril 2021.

[8] Définition du « profilage » dans le RGPD : « toute forme de traitement automatisé de données à caractère personnel consistant à utiliser ces données à caractère personnel pour évaluer certains aspects personnels relatifs à une personne physique, notamment pour analyser ou prédire des éléments concernant le rendement au travail, la situation économique, la santé, les préférences personnelles, les intérêts, la fiabilité, le comportement, la localisation ou les déplacements de cette personne physique ».

[9] Techniques listées en annexe 1 de la proposition de règlement dite « Artificial Intelligence Act ».

Bibliographie

DEVILLERS, L. (2019). Les robots « émotionnels » : santé, surveillance, sexualité… : et l’éthique dans tout ça ?, Editions de l’Observatoire.

DUDÉZERT, A., (2018). « III. La nouvelle équation managériale », dans : Aurélie Dudézert éd., La transformation digitale des entreprises. Paris, La Découverte, « Repères », 85-109.

CRICHTON, C. (2021), « Projet de règlement sur l’IA (II) : une approche fondée sur les risques », Dalloz Actualités, mis en ligne le 4 mai 2021, consulté le 15 octobre 2021. URL

KALLE, L., KING, J. L. (2006). « Standard Making: A Critical Research Frontier for Information Systems Research », MIS Quarterly, vol. 30, Management Information Systems Research Center, University of Minnesota, 405–11, https://doi.org/10.2307/25148766.

KAPLAN, A., & HAENLEIN, M., (2020). « Rulers of the world, unite! The challenges and opportunities of artificial intelligence », Business Horizons, 2020, vol. 63, issue 1, 37-50.

KOLBJØRNSRUD, V., AMICO, R., & THOMAS, R. J. (2017). « Partnering with AI: How organizations can win over skeptical managers ». Strategy and Leadership, 45(1), 37-43.

LAURENT, M., KHATCHATOUROV, A. (2018) « La confiance en informatique par la gestion du risque ». Signes de confiance : l’impact des labels sur la gestion des données personnelles, Institut Mines-Télécom, 47-62.

MAKARIUS, E., MUKHERJEE, D., FOX, J. et FOX, A. (2020). « Rising with the machines: A sociotechnical framework for bringing artificial intelligence into the organization », Journal of Business Research, 120, 262-273. https://doi.org/10.1016/j.jbusres.2020.07.045.

MENECEUR, Y. (2021), « L’ambitieux projet d’Artificial Intelligence Act de la Commission européenne », Actu IA, n°4, 15 mai 2021, 31.