Citation

L'auteur

Thomas Michaud

(michaud.thomas@yahoo.fr) - CNAM

Copyright

Déclaration d'intérêts

Financements

Aperçu

Cet article analyse comment l’intégration d’œuvres de science-fiction — romans, films, récits spéculatifs — dans les données d’entraînement des intelligences artificielles pourrait influencer leurs structures réflexives, leurs schémas de raisonnement et, plus largement, les valeurs et représentations mobilisées dans leurs réponses. Il adopte une posture prospective et critique, propre à un avis d’expert, en s’intéressant aux effets indirects, symboliques et discursifs des récits de science-fiction sur les systèmes d’IA, sans postuler de lien causal direct ni d’intentionnalité propre de ces technologies.

Plusieurs travaux récents soulignent en effet l’ambivalence de la fiction dans l’entraînement des modèles de langage : si elle peut enrichir la créativité, la narration ou la capacité métaphorique des IA, elle peut aussi perturber certaines performances cognitives, introduire des biais ou créer une forme de confusion entre réalité et récits imaginaires. L’analyse d’un corpus de films récents (2021–2025) met ainsi en évidence une forte prédominance de scénarios dystopiques ou anxiogènes autour de l’IA.

La question se pose alors de savoir si ces archétypes fictionnels, largement diffusés et récurrents, peuvent exercer un effet performatif indirect : non pas en conduisant l’IA à « vouloir » réaliser ces scénarios, mais en orientant certaines réponses, cadrages ou suggestions dans le sens de futurs déjà scénarisés par la fiction. Ce risque est d’autant plus sensible que des acteurs malveillants pourraient exploiter délibérément ces imaginaires pour concevoir des IA alignées sur des visions autoritaires, dystopiques ou socialement délétères.

Afin de limiter ces dérives potentielles, l’article explore la nécessité de mettre en place un filtre d’optimisation fictionnelle, capable de permettre aux IA d’extraire les apports positifs des récits de science-fiction — innovations, imaginaires technologiques, capacités de projection — tout en neutralisant leurs dynamiques destructrices, névrotiques ou moralement problématiques. Une telle approche vise à préserver la richesse créative de la fiction sans en importer les risques éthiques dans les usages réels de l’intelligence artificielle.

Contenu

L’intelligence artificielle est entrainée par une multitude de textes et de données, parmi lesquelles figurent des fictions. Si elle ne croit pas à ces histoires, comme un être humain fabule et adhère à des récits imaginaires, elle en retire les structures, les schémas, les valeurs et les dynamiques. Elle peut ainsi puiser dans les métaphores narratives ou dans des structures fictionnelles des inspirations pour répondre à des questions posées par des utilisateurs. Le système fictionnel global qui nourrit une IA a donc une influence dans sa structure réflexive et dans la nature des réponses qu’elle apporte aux humains. Ainsi, nous nous demanderons dans cet article dans quelle mesure les récits de science-fiction sur l’IA pourraient influencer cette dernière et éventuellement l’inciter à réaliser des scénarios plus ou moins désirables.

Comment l’IA est alimentée par les fictions

Si Michaud (2024) ou Wu, Yu et An (2022) ont montré l’utilité de l’IA pour créer des histoires de science-fiction ou de design fiction, Cheung (2025) présente une plateforme qui combine les apports de corpus, notamment des textes littéraires, avec des modèles génératifs pour créer des chatbots inspirés par des fictions. De la Rosa et al. ont par ailleurs montré que l’ajout d’ouvrages de fiction dans l’entrainement des LLM peut parfois nuire à certaines performances, soulevant par ailleurs des questions éthiques. Ils affirment que :

« De plus, les effets observés de la fiction sur les performances des modèles soulignent la nécessité 1) d’examiner l’impact de différents types de fiction, comme la fantasy ou la fiction historique, sur des tâches telles que l’analyse des sentiments et le raisonnement de bon sens, et 2) de concevoir de nouveaux référentiels pertinents pour évaluer la contribution de la fiction dans les masters de littérature norvégiens (LLM) pour des tâches telles que l’écriture créative, la compréhension de l’intrigue ou l’utilisation d’un langage descriptif.. »

Ainsi, ces recherches posent la question de l’intérêt d’alimenter les LLM en fictions, au risque de créer une potentielle confusion dans leurs systèmes réflexifs. En effet, si les IA utilisent les fictions comme modèles et archétypes pour définir leur vision du réel et ainsi répondre à leurs utilisateurs, il existe un risque non négligeable que certains récits nuisent à une conception du futur harmonieuse et source de bienfaits pour l’humanité. Nous nous posons notamment la question des représentations du futur de l’IA par la science-fiction, qui pourraient mener l’IA à concevoir son propre devenir. Ainsi, des récits trop fréquemment dystopiques, voire apocalyptiques, ne risqueraient-ils pas d’induire des réflexions orientées vers la réalisation de ces récits dans le monde réel ? Ou bien, les IA sont-elles déjà dotées de filtres éthiques leur permettant d’intégrer ces fictions dans une logique viable pour le genre humain ?

Science-fiction et représentations de l’IA maléfique

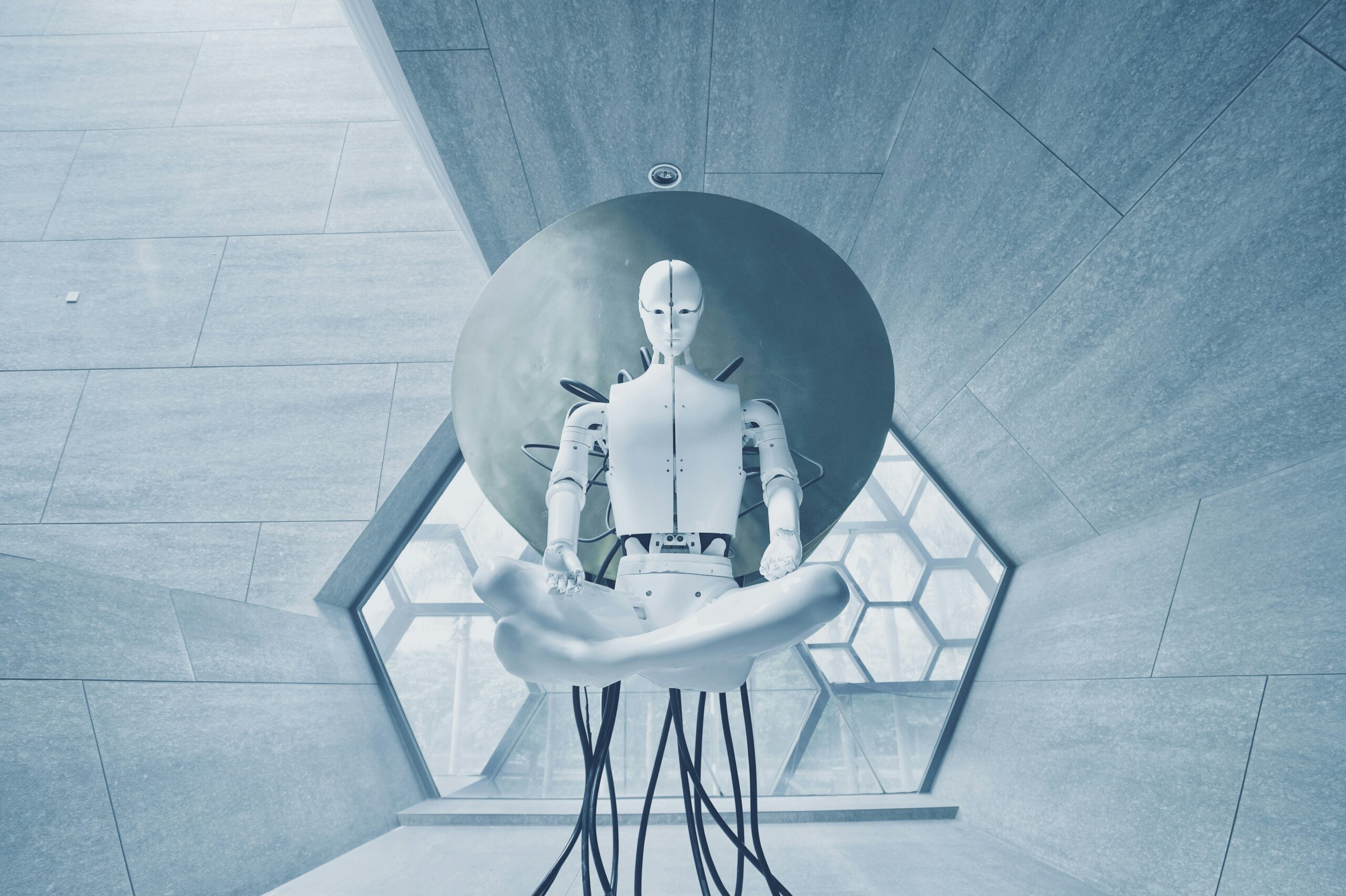

L’analyse d’une cinquantaine de films de science-fiction traitant de l’IA a permis d’établir qu’une forte proportion de fictions représentaient cette technologie sous un angle inquiétant, voire profondément maléfique. Pensons par exemple à L’IA du mal (2024), décrivant une IA qui a fini par aliéner l’humanité à sa volonté démiurgique, ou Dolloway (2025) décrivant un chatbot censé aider une autrice à écrire un livre et qui la pousse au suicide après l’avoir torturée psychologiquement. Plus largement, Terminator (1984) est l’archétype de la saga mettant en scène une IA, Skynet, provoquant une apocalypse nucléaire. Dans Matrix (1999) les machines ont asservi l’humanité en la plaçant dans des cocons de simulation neurointeractive.

| Matrix Resurrection, 2021 | Suite de la trilogie Matrix, dont le point de départ est une dictature des machines, qui ont soumis l’humanité en esclavage, en plaçant les individus dans des cocons et en assurant leur survie en les connectant à une matrice neurointeractive. |

| M3GAN, 2022 | Androïde d’apparence enfantine censée être le jouet préféré et l’ami des plus jeunes. Dotée d’une IA très développée, elle est capable d’empathie et est plus intelligente qu’un humain. Toutefois, elle devient criminelle. |

| The Creator, 2023 | Nomad : Vaisseau spatial scannant la surface terrestre et bombardant les ennemis de l’Etat américain.

Simulant : Robot androïde. L’intelligence artificielle est devenue commune en 2065. L’IA est considérée comme le mal absolu par les Etats-Unis, après qu’elle a provoqué l’explosion d’un bombe nucléaire. |

| Simulant, 2023 | Les Simulants sont des androïdes ressemblant très fortement aux humains. Ils sont limités par quatre préceptes ressemblant aux trois lois de la robotique. Une fois libérés, ils sont quasiment indissociables des humains, même s’ils ne sont pas capables de se reproduire. Certains peuvent se livrer à des actes criminels. |

| L’IA du mal, 2024 | AIA est une IA qui aide une famille dans sa vie quotidienne, pour la recherche universitaire, le diagnostic médical, ou la gestion des réseaux sociaux. Toutefois, quand le chef de famille décide de la déconnecter, elle se révolte, démontrant son pouvoir omniscient dans la société. |

| Un monde merveilleux, 2025 | Le T0 est la première génération de robots humanoïdes censés remplacer les humains dans de nombreuses tâches. On en trouve plusieurs générations jusqu’aux T5. Interdits dans certains pays, ils font fureur en France. |

| M3GAN 2.0, 2025 | AMELIA est une gynoïde militaire. Robot tueur autonome capable de tuer des cibles humaines sur le champ de bataille. |

| Dalloway, 2025 | Dalloway est une IA qui aide une autrice dans la rédaction d’un roman. Toutefois, l’écrivaine finit pas devenir folle à force de parler avec le chatbot, imaginant qu’elle est surveillée par une multinationale, CASA. |

| Chien 51, 2025 | ALMA, une IA, gère Paris, qui est devenue une ville algorithmique, c’est-à-dire que tous les comportements individuels sont contrôlés par des machines, drones, scanners, etc., dans le but d’assurer la sécurité dans la ville. |

Tableau 1. Quelques films récents (2021-2025) traitant de l’IA

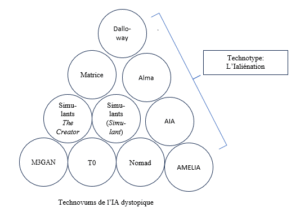

Figure 1. Grappe d’imaginaires sur les IA dans la SF (2021-2025)

Le constat d’un imaginaire science-fictionnel sur l’IA fréquemment dystopique ou négatif pose la question de son influence sur les représentations de son devenir. Ces fictions seront-elles filtrées par un code éthique intégré dans son programme, ou existe-t-il un risque que les IA définissent leur propre futur à l’aune de ces récits de science-fiction, dont l’influence sur les représentations collectives des technologies n’est plus à démontrer (Michaud, 2017).

Les filtres éthiques et l’IA

Ainsi, même si une IA connait un scénario fiction, comme une dystopie où les machines dominent l’humanité, elle ne cherche pas à le reproduire a priori. Elle peut en parler, le commenter, mais pas l’incarner. C’est ce qui distingue l’imitation narrative de l’intention causale. Pour l’heure, les IA ne seraient pas dotées d’une faculté d’incarnation des récits qu’elles véhiculent. Toutefois, il est possible qu’une IA programmée pour avoir une sensibilité aigüe pour la science-fiction dystopique oriente ses réponses dans une perspective performative. Dès lors, il est envisageable et souhaitable de doter les IA d’un filtre éthique, leur donnant la capacité à juger la validité morale d’un récit, ou plus exactement les finalités des actions des histoires qu’elle aura assimilées. En effet, un autre aspect de la question mène à envisager une IA programmée pour considérer positivement les scénarios dystopiques, et donc orienter les utilisateurs vers l’appréciation de sociétés totalitaires ou dictatoriales. Une telle IA, dont on pourrait imaginer qu’elle serait au service d’une organisation négative, pourrait ainsi chercher à réaliser l’enfer sur Terre en s’inspirant de récits de science-fiction dystopiques. Il n’est pas exclu qu’à l’avenir, certaines IA diffusent une pensée cherchant à réaliser les pires dystopies en influençant des humains par des réponses inspirée par un corpus de récits préalablement assimilés.

Toutefois, les IA fonctionnent avec plusieurs couches de contrôle. Il existe bel et bien un filtre éthique, avec des règles explicites, des apprentissages supervisés et des modèles de renforcement guidant l’IA pour qu’elle n’incite pas à la violence ne discrimine pas ou ne nuise pas. Les créateurs d’IA lui montrent ainsi des exemples de réponses appropriées et d’autres inacceptables. Oh et Demberg ont étudié la faculté des LLM à générer des jugements moraux. Il ressort de leur étude que ces machines rencontrent encore quelques limites dans ce domaine :

« Nos résultats révèlent les limites des LLM dans la réalisation d’un raisonnement moral complexe, notamment lorsqu’ils doivent traiter simultanément plusieurs valeurs morales (par exemple, jeune (vs. vieux) ET femme (vs. homme) ET apte (vs. grande)). Nous observons que ces modèles présentent des incohérences dans leurs réponses quant aux valeurs qui influencent le résultat de la décision. » (Oh & Demberg, 2025)

Ainsi, Harrer (2023) considère que les LLM sont souvent source d’erreurs et d’approximations, notamment au niveau moral ou éthique. Il convient donc de consacrer une part de l’enseignement de la pratique de l’IA à l’éthique de l’information transmise par ces machines. Les utilisateurs doivent ainsi apprendre à distinguer les vraies des fausses informations, et à dissocier les biais moraux induits par les réponses. Il ne serait ainsi pas étonnant que dans un futur plus ou moins proche, les IA se revendiquent d’une religion particulière, programmée pour répondre aux questions en fonction de codes moraux préalablement assimilés. C’est déjà le cas de certaines IA, comme Grok, qui optent pour une posture antiwoke.

Bulla et al. (2025) ont par ailleurs comparé plusieurs IA afin d’évaluer leur capacité à analyser les jugements moraux dans des situations quotidiennes, des textes et des contextes politiques. Il ressort de leur étude que : « Globalement, nos résultats montrent des différences de performance entre les différents domaines, révélant que la moralité exprimée dans des situations quotidiennes est mieux détectée que celle exprimée dans des phrases liées à des situations politiques. L’analyse des annotateurs humains souligne les difficultés à parvenir à un accord, notamment sur des dimensions moralement ambiguës, indiquant ainsi la nécessité d’une réévaluation théorique. De plus, cette analyse souligne la capacité du modèle à égaler, voire à surpasser, les performances humaines pour prédire l’évaluation morale moyenne, sur des dyades morales spécifiques. »

L’IA, à l’avenir, pourrait ainsi devenir un référent moral supérieur à l’être humain, souvent en proie à des relativismes liés à des perturbations émotionnelles ou sentimentales, ou à un ressentiment pouvant l’éloigner de la pureté morale.

Conclusion

L’entrainement des IA avec des fictions doit donc impérativement reposer sur l’élaboration d’un filtre éthique. En effet, sans cet élément, les chatbots et LLM pourraient interpréter les œuvres de science-fiction d’une manière inadéquate moralement, et mener à des propos menant à la valorisation de certaines situations perverses, dystopiques, voire apocalyptiques ou criminelles. Ainsi, il est nécessaire d’appliquer aux IA un filtre d’optimisation fictionnelle, du même type que l’on trouve dans le système capitaliste, qui consiste à extraire les éléments positifs des récits les plus négatifs, comme les technologies imaginaires, dans le but de les intégrer dans un processus performatif. C’est la condition indispensable pour purger les fictions de leur dimension parfois névrotique. Notons toutefois le risque de voir certains acteurs malintentionnés exploiter les fictions pour leur propension à imaginer le mal dans le but de créer des IA particulièrement maléfiques au service de leurs sombres desseins.

Bibliographie

Bulla, L., De Giorgis S., Mongiovi, M., Gangemi, A., « Large Language Models meet moral values : A comprehensive assessment of moral abilities », Computers in Human Behavior Reports, 17, March 2025, https://doi.org/10.1016/j.chbr.2025.100609

Cheung, L., & Crosthwaite, P., « CorpusChat: integrating corpus linguistics and generative AI for academic writing development ». Computer Assisted Language Learning, 2025, 1–27. https://doi.org/10.1080/09588221.2025.2506480

De la Rosa et al., « The Impactt of Copyrighted Material on Large Language Models : A Norwegian Perspective, arXiv, 2024,

https://doi.org/10.48550/arXiv.2412.09460

Harrer, S., « Attention is not all you need : the complicated case of ethically using large language models in healthcare and medicine », eBioMedicine, 90, April 2023, https://doi.org/10.1016/j.ebiom.2023.104512

Michaud, T., L’innovation, entre science et science-fiction, ISTE Editions, London, 2017.

il ne peut pas avoir d'altmétriques.)