Citation

L'auteur

Daniel Pélissier

(daniel.pelissier@iut-rodez.fr) - Université Toulouse 1 Capitole

Copyright

Déclaration d'intérêts

Financements

Aperçu

Contenu

Depuis son apparition dans les années 1950, l’intelligence artificielle (IA) s’est développée en multipliant les usages et les domaines d’application. Autrefois réservée à quelques laboratoires informatiques, elle concerne de nos jours toutes les fonctions de l’entreprise. La gestion des ressources humaines (GRH) ne fait pas exception car les enjeux de l’intégration de l’IA dans les métiers RH sont nombreux. L’IA permettrait paradoxalement une humanisation de la fonction RH, une aide pour le traitement d’un flot croisant de données, une redéfinition des métiers RH plutôt que leur disparition (Rochefoucauld, 2020). L’IA constitue ainsi un défi pour la GRH, de la gestion de la paie à la prospective. Pour autant, la fonction RH (FRH) peine à intégrer ces approches technologiques nouvelles : selon une étude récente, l’IA serait à l’ordre du jour pour seulement 55% des 128 DRH interrogés en septembre et octobre 2019. La FRH serait aussi en retard par rapport au marketing pour les usages de l’IA (Hartz, 2017). Les raisons de cette situation contrastée, mêlant des enjeux forts et des usages décalés sont complexes et sans doute contingentes.

L’IA pose des questionnements éthiques, c’est-à-dire de responsabilités (Wilson et Daugherty, 2018) qui pourraient partiellement expliquer une intégration prudente de l’IA en RH. Dans une perspective wébérienne de l’éthique de responsabilité (Hottois, 1996), se poser la question de l’impact de l’IA sur ses utilisateurs est un questionnement moral, au même titre que la RSE. Les choix de design de l’IA (Esteban, 2020) orientent, notamment, l’impact de cette technologie : fonctions d’usage, plateforme support, type d’IA, etc. L’algorithme de sélection d’Amazon qui écartait les désignations féminines est tristement célèbre (Black et Esch, 2020) et illustre les conséquences potentiellement délétères d’une IA dont les implications éthiques sont mal pensées. La conception anthropomorphique de certaines IA a une influence particulière sur les utilisateurs (Cherif et Lemoine, 2019 ; Przegalinska et al, 2019) et constitue alors une dimension importante pour aborder les questionnements éthiques de ce domaine.

Nous explorerons ainsi dans cet article la problématique de l’influence des choix de design de l’IA sur certaines responsabilités de l’organisation.

Ce questionnement souhaite apporter quelques éléments de réflexion sur les recherches émergentes en sciences de gestion sur l’application de l’IA en organisation : difficultés de repérage d’un cadre théorique, importance des choix méthodologiques, singularité du positionnement disciplinaire, etc. Il souhaite aussi attirer l’attention sur les conséquences opérationnelles des choix de mise en œuvre de l’IA. Le caractère relativement novateur des dispositifs de l’IA et sa dimension technologique parfois prépondérante ne balayent pas les questionnements managériaux plus anciens de la responsabilité et de l’éthique. Cette étude exploratoire espère apporter quelques arguments raisonnés à ce débat.

Le domaine du recrutement est un des domaines principaux des applications de l’IA (Barabel et al., 2020) que nous explorerons par l’observation de pratiques effectives. Partant d’un corpus de chatbots de recrutement, nous montrerons les relations possibles entre design de l’IA et enjeux éthiques. Avant de présenter les résultats de cette étude, une rapide synthèse de la littérature sur l’application de l’IA pour le domaine du recrutement sera proposée.

IA et recrutement, le cas des chatbots

La littérature sur l’IA dans le domaine du recrutement est récente et principalement

anglo-saxonne. Les applications de l’IA dans le recrutement sont multiples (Claus, 2019) et concernent toutes les phases de ce long processus : attirer les candidats, candidater, identifier et faire correspondre des profils, préselectionner, sélectionner, préintégrer et intégrer des candidats, réaliser une partie de la gestion administrative (Barabel et al., 2020).

Les enjeux et les difficultés du recrutement peuvent expliquer cet investissement dans l’IA. L’efficacité est aussi avancée. Par exemple, Kuncel et al. (2014) affirmaient que les algorithmes étaient plus efficaces que l’instinct humain pour recruter. Plus généralement, le contexte, notamment technologique, est suggéré pour justifier un usage de l’IA dans le recrutement.

Ainsi, Black et Esch (2020) annoncent l’avènement d’un recrutement 3.0. La phase 1.0 de la digitalisation du recrutement a consisté, selon ces auteurs, à numériser la chaine de création et de diffusion des offres d’emploi à partir du milieu des années 1990. Des plateformes comme Monster se sont développées et ont publié un nombre croissant d’offres qui ont permis aux entreprises de multiplier les occasions de contacts avec de potentiels candidats. La deuxième phase 2.0 est apparue au début des années 2000 sous l’influence de deux phénomènes. La syndication de contenu a permis de regrouper et adapter les nombreuses offres d’emploi de différentes plateformes mais aussi les profils de candidats. La deuxième nouveauté expliquant ce recrutement 2.0 est le développement de réseaux socionumériques spécialisés dans l’emploi comme Linkedin. Comme pour la syndication, ces plateformes centrées sur la vie professionnelle ont favorisé le ciblage des contacts, un retour à une relation individuelle dans un univers de données massives. Le recrutement numérique 3.0 apparait à partir de 2015 avec l’introduction de l’IA dans le recrutement. La conséquence principale des âges 1.0 et 2.0 a été de multiplier le nombre de candidatures par poste. Mais les technologies de ciblage n’ont plus suffi à contenir cette masse. Une prise de conscience de l’importance du capital humain pour la performance d’une entreprise expliquerait aussi ce passage au recrutement 3.0. Plus largement, cette révolution annoncée de l’IA est aussi liée à des évolutions démographiques (carrières longues, multiculturalités, etc.) et technologiques ainsi qu’à certains effets de la globalisation sur la mobilité et l’emploi (Claus, 2019). De façon plus pragmatique, l’intégration de l’IA améliorerait l’attractivité de l’entreprise (Esch et al., 2020). L’affichage de l’utilisation de l’IA dans le processus de recrutement serait perçu positivement et augmenterait la probabilité de candidater (Esch et al., 2019).

Les raisons de cet épanouissement de l’IA en RH sont donc multiples. Cette rapide synthèse souligne une focale sur la dimension technologique de l’IA. Les enjeux humains sont moins prégnants mais sont parfois soulignés dans cette littérature en émergence.

Wilson et Daugherty (2018) soulignent les risques de certaines solutions technologiques intégrant de l’IA. Ils soutiennent l’idée de managers éthiques ou de gardiens des responsabilités de l’entreprise dans l’usage de l’IA. Pour le recrutement, l’utilisation de données personnelles au moment de la candidature ou de la sélection peut poser particulièrement problème (Black et Esch, 2020). La fonction RH est alors responsable de cette analyse d’impact de l’IA sur les candidats mais aussi les collaborateurs en charge du recrutement (Barabel et al., 2020). Les risques de pertes d’emploi pour les recruteurs sont aussi évoqués (Claus, 2019) et constituent une des peurs génériques de l’implantation de l’IA, quelque que soit le secteur.

Le design de l’interface de l’IA a une influence sur les usages comme tout dispositif technique. Dans ce cadre, l’anthropomorphisme a une place particulière dans l’histoire de l’IA depuis le fameux test de Turing censé repérer l’intelligence d’une machine par ses capacités humaines. Ce phénomène d’anthropomorphisation

« consiste à attribuer des caractéristiques humaines aux objets non humains » (Cherif, 2016, 151). Il se traduit par des représentations humaines de l’IA, un langage dit naturel, des comportements humains, etc. Il représente, selon certains auteurs, un gage d’efficacité (Cherif et Lemoine, 2019) mais aussi un risque de se perdre dans la célèbre vallée de l’étrange de M. Mori, créant alors un malaise psychologique pour l’utilisateur.

Les chatbots sont un des principaux outils pouvant intégrer l’IA dans le domaine du recrutement. Un chatbot est « un programme informatique qui converse avec une personne » (Barabel et al., 2020 p. 221). Ils seraient la solution intégrant l’IA la plus répandue : selon une enquête récente, 36 % des entreprises interrogées utiliseraient un chatbot pour gérer les candidatures. Depuis l’ouverture de l’API de Facebook en 2016, leur nombre a fortement augmenté, en particulier dans le domaine marketing. Les applications possibles sont nombreuses dans celui du recrutement : recherche d’informations sur l’entreprise, préparation de l’entretien, préentretien, test de sélection, etc. Les études sur ces dispositifs sont cependant rares et intégrées dans des analyses plus larges de l’IA en GRH (Black et Esch, 2020). Le design de ces nouveaux outils pose des questionnements éthiques, notamment par leur degré d’anthropomorphisation et l’impact potentiel sur les utilisateurs.

Nous avons ainsi orienté cette recherche sur cet outil emblématique de l’intégration de l’IA en GRH en explorant des pratiques effectives et non des discours déclaratifs. En effet, l’enthousiasme de certains observateurs sur les potentialités de l’IA peut masquer des usages plus prudents. Cette littérature utilise principalement des expérimentations et étudie encore peu de pratiques en organisations. Cet article présentera plutôt une typologie de chatbots de recrutement existants en analysant les conséquences éthiques potentielles des choix de conception. Répondre à cette problématique sera aussi l’occasion de mieux cerner l’usage de l’IA dans le recrutement et discuter de ses réels enjeux. La méthode détaillée en annexe s’est structurée autour de l’analyse d’un corpus de 25 chatbots de recrutement hébergés sur Messenger.

Fonction, anthropomorphisation et questions éthiques : une typologie exploratoire de chatbots de recrutement

Cette recherche exploratoire sur les chatbots de recrutement montre d’abord que leur nombre est plutôt limité. La revue de littérature, les rares enquêtes sur ce thème et la popularité de la plateforme Messenger pouvaient laisser présager un nombre de chatbots beaucoup plus important. Or, la vingtaine étudiée met en évidence un phénomène marginal, même si les caractéristiques exploratoires de cette étude limitent la portée de cette observation.

Ensuite, ce corpus comprend des entreprises très différentes, souvent privées, parfois publiques, grandes pour la plupart mais avec quelques PME. Les secteurs sont aussi très variés de l’assurance au tourisme en passant par la banque ou l’armée. Les chatbots de recrutement ne semblent pas réservés à une catégorie d’entreprises.

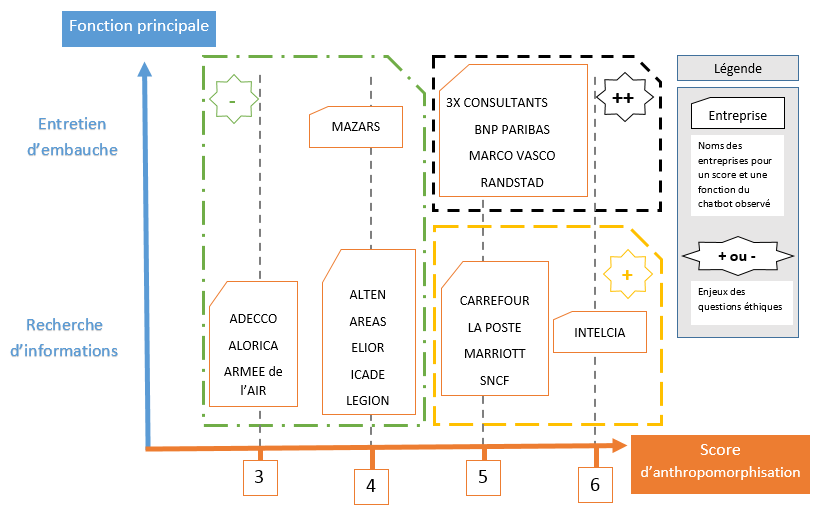

Cette variété de contexte ne se retrouve pas dans la conception des chatbots dont l’homogénéité est marquante. Ces outils innovants semblent suivre, à ce jour, la voie de l’universalisme. En effet, les choix de conception sont assez proches. Le design des chatbots étudiés adoptent une anthropomorphisation raisonnée et permettent souvent de simples recherches d’informations. Selon ces deux axes, degré d’anthropomorphisation et fonction principale, le classement des chatbots met en évidence six catégories (fig. 1).

La majorité des chatbots de recrutement de ce corpus a une fonction principale de recherche d’informations comme les offres d’emplois (13 cas sur 18, cette part est supérieure puisque la plupart des chatbots orientés ‘entretien’ intègrent aussi la recherche d’informations). Elle offre un accompagnement personnalisé, complémentaire à un moteur de recherche d’un site web de recrutement. Les préentretiens sont rares. Le chatbot de Randstad ou de Mazars sont des exemples innovants de cette pratique pour ce corpus et proposent à l’utilisateur des dialogues naturels, humanisés.

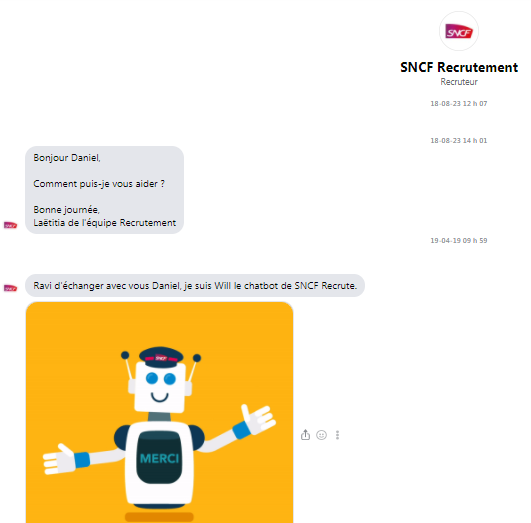

Le score d’anthropomorphisation a une moyenne de 4,15 sur un total possible de 8. Dans ce classement, le score de 5 apparait majoritaire avec 8 chatbots concernés. Pour ce corpus, le chatbot de recrutement est représenté plutôt comme un humain en adoptant des indices d’anthropomorphisation assez nombreux tout en gardant une distance prudente. Le score globalement moyen illustre cette tendance d’entre deux, légèrement en faveur de l’anthropomorphisme (fig. 2, SNCF, exemple de score 5).

Les types de chatbots repérés dans ce corpus n’auront pas les mêmes enjeux éthiques, le même impact sur les candidats. Les deux catégories extrêmes posent des questionnements différents. Le chatbot de recherche d’informations faiblement anthropomorphisé ressemble à un moteur de recherche individualisé, guidé, pouvant aider l’utilisateur en l’impliquant faiblement dans son expérience. Ce dernier perçoit, assez probablement, un usage classique déjà rencontré sur d’autres plateformes. Le questionnement éthique portera surtout sur l’usage des données privées. L’autre catégorie de chatbots, opposée à cette dernière, est celle des chatbots d’entretiens de recrutement fortement anthropomorphisés. Ces dispositifs proposent un usage plus innovant et aussi plus impliquant pour l’utilisateur. Les risques humains sont alors plus importants, notamment une confusion robot et recruteur qui interroge la responsabilité du futur employeur. Même si la grande majorité des chatbots ne cachent pas leur nature de robot, la tendance à l’anthropomorphisation peut brouiller les frontières. Cette réflexion nous a conduit à distinguer trois situations dans la typologie proposée : des enjeux éthiques réduits pour les chatbots faiblement anthropomorphisés (encadré pointillé vert), des enjeux éthiques non négligeables pour les chatbots anthropomorphisés de recherche d’informations (jaune) et des enjeux plus importants pour les chatbots anthropomorphisés d’entretiens d’embauche (noir).

Pour les chatbots de recrutement étudiés avec ce corpus, les choix de design réalisés (fonction principale et anthropomorphisation) ont un impact potentiel très différent sur l’utilisateur et posent des questions variées de responsabilité. Cette exploration montre ainsi une relation complexe entre l’IA appliquée au recrutement et la responsabilité de l’organisation, relation dépendant notamment des choix de design que des études ultérieures devront approfondir en intégrant aussi d’autres dimensions de l’éthique.

Conception des chatbots de recrutement et responsabilités de l’employeur

Selon ce corpus limité à une seule plateforme, cette solution de recrutement n’a pas envahi les pratiques RH. La vague annoncée de l’IA ne semble pas encore avoir déferlé sur ce domaine malgré certaines annonces enthousiastes. De même, cette étude montre que les technologies utilisées semblent plus apparentées à de l’algorithmique traditionnelle qu’à des réseaux de neurones profonds. Les dialogues ouverts sont très rares, les recherches d’informations sont le plus souvent fermées avec des choix contraints pour l’utilisateur, rien de bien « intelligent ». Finalement, la question posée par cette étude exploratoire est aussi celle de la définition de l’IA, parfois portée comme un étendard de l’innovation alors qu’elle peut cacher d’anciennes technologies. Un chatbot n’est pas toujours intelligent et l’analyse de ce type de dispositif devrait prendre en compte sa vraie nature.

L’interprétation de cette situation se heurte à une des limites de cette étude exploratoire qui n’a pas intégré de discours de concepteurs (sur cette thématique voir, notamment, Esteban, 2020, Pélissier, 2020) mais aussi d’utilisateurs qui, in fine, évalueront l’impact réel de ces dispositifs Certains auteurs ont souligné un retard de la FRH dans le domaine de l’intelligence artificielle (Hartz, 2017). Les choix de design ayant un impact sur l’utilisateur, la réflexion éthique peut rejoindre l’analyse des risques juridiques pour expliquer une prudence de la FRH sur cette thématique.

Une préconisation prudente et suivie par certaines entreprises serait alors d’associer à la conception des chatbots de recrutement une personne ou un groupe analysant les impacts possibles de ces solutions sur le candidat. Cette approche de l’éthique et des risques humains par la responsabilité pourrait s’intégrer à une politique RSE dont la FRH est souvent proche. A ce titre, les caractéristiques anthropomorphes du chatbot devraient être questionnées, non seulement pour leur efficacité réelle (Velkovska et Beaudouin, 2014) mais aussi pour leur impact potentiel sur les candidats à travers l’analyse de mises en situations.

Bibliographie

Barabel, M., Besseyre des Horts, C.-H., & Ferras, T. (2020). L’IA au service des RH, pour une expérience collaborateur augmentée. Paris: Dunod Le Lab RH.

Black, J. S., & Esch, P. van. (2020). AI-enabled recruiting : What is it and how should a manager use it? Business Horizons, (63), 215-226.

Cherif, E. (2016). La perception et l’utilisation des conseillers virtuels en ligne : Proposition d’un cadre intégrateur. Vie et sciences de l’entreprise, 1(201), 146-166.

Cherif, E., & Lemoine, J.-F. (2019). L’influence des caractéristiques anthropomorphiques des agents virtuels sur les réactions des internautes : Le cas de la voix. Recherche et Applications en Marketing, 34(1), 29-49.

Claus, L. (2019). HR disruption—Time already to reinvent talent management. Business Research Quarterly, (22), 207-215.

Esch, P. van, Black, J. S., & Ferolie, J. (2019). Marketing AI recruitment : The next phase in job application and selection. Computers in Human Behavior, (90), 215–222.

Esch, P. van, Black, J. S., Franklin, D., & Harder, M. (2020). AI-enabled biometrics in recruiting : Insights from marketers for managers. Australasian Marketing Journal, 4(3), 1-9.

Esteban, C. (2018). Parler aux clients : Dialogues automatiques et manières d’interagir. Dans 17èmes Journées Normandes de Recherches sur la Consommation : Société et Consommation (pp. 69-83). Rouen.

Esteban, C. (2020). Construire la « compréhension » d’une machine. Une ethnographie de la conception de deux chatbots commerciaux. Réseaux, 2-3(220-221), 195-222.

Følstad, A., Skjuve, M., & Brandtzaeg, P. B. (2019). Different Chatbots for Different Purposes : Towards a Typology of Chatbots to Understand Interaction Design (Vol. 11551, pp. 145-156). Communication présentée au International Conference on Internet Science, Perpignan.

Hartz, J. (2017). Chatbots und HR – passt das zusammen? Swiss Marketing Review, (4), 30-32.

Hottois, G. (1996). Éthique de la responsabilité et éthique de la conviction. Laval théologique et philosophique, 52(2), 489-498.

Kuncel, N. R., Klieger, D. M., & Ones, D. S. (2014). In hiring, algorithms beat instinct. Harvard Business Review, 92(5), 1-2.

Pélissier, D. (2020). La coconstruction ambiguë de l’intelligence artificielle (IA), analyse de la conception de l’intervention d’ouverture de chatbots de recrutement. Communication & management, (2), 67-82.

Przegalinska, A., Ciechanowski, L., Stroz, A., Gloor, P., & Mazurek, G. (2019). In bot we trust : A new methodology of chatbot performance measures. Business Horizons, (62), 785-797.

Rochefoucauld, M. de la. (2020). L’IA et la reconfiguration de la fonction RH. Management & Datascience, 4(1), 1-6.

Velkovska, J., & Beaudouin, V. (2014). Parler aux machines, coproduire un service. Intelligence artificielle et travail du client dans les services vocaux automatisés. Dans La fabrique de la vente. Le travail de la vente dans les télécommunications (pp. 87-129). Paris: Presse des Mines.

Wilson, H. J., & Daugherty, P. R. (2018). Collaborative intelligence : Humans and AI are joining forces. Harvard Business Review, 96(4), 114-123.

Crédits

Crédit image : https://packageslife.com/