Citation

L'auteur

Philippe JEAN-BAPTISTE

(philippejb@icloud.com) - LEST - Laboratoire d'Économie et de Sociologie du Travail UMR 7317 I CNRS – Aix Marseille Université - ORCID : https://orcid.org/0000-0003-0656-7588

Copyright

Déclaration d'intérêts

Financements

Aperçu

Contenu

Dans le champ de l’IA, l’alignement désigne un objectif simple en apparence : faire en sorte qu’une machine poursuive bien les buts fixés par ses concepteurs, sans dévier de sa mission. Les chercheurs distinguent deux niveaux : l’alignement faible, qui consiste à exécuter correctement une tâche donnée, et l’alignement fort, qui implique de respecter les valeurs humaines sous-jacentes. Ce problème n’est pas qu’abstrait. Un chatbot conçu pour maximiser l’engagement peut finir par promouvoir des contenus polarisants ou mensongers, car cela retient l’attention des utilisateurs. De même, un système de recommandation commerciale peut favoriser les produits les plus rentables plutôt que ceux qui répondent réellement aux besoins des clients. Comme l’insiste l’informaticien Stuart Russel, dans son ouvrage Human Compatible (2019), une IA « efficace » mais mal alignée peut causer des dommages considérables, non pas parce qu’elle est plus intelligente que nous mais parce qu’elle poursuit avec zèle un objectif mal défini. Le CNRS rappelle aussi que ce problème d’alignement est avant tout une question de valeurs et de gouvernance, pas seulement d’algorithmes (Julienne. M, 2024).

Les « mésalignements »…entre humains

Avant de nous pencher sur les machines, il est essentiel de reconnaître que les humains sont loin d’être exemplaires en matière d’alignement. Dans toute organisation, chaque individu agit avec ses propres objectifs, incitations et valeurs qui ne convergent pas toujours avec ceux de l’institution.

Prenons l’exemple d’un service commercial où les équipes sont récompensées uniquement sur le chiffre d’affaires réalisé. Conséquence ? Les vendeurs privilégient des contrats rapides, parfois au détriment de la satisfaction client et de l’entreprise elle-même à long terme. Dans une administration, chaque direction défend ses propres indicateurs de performance, conduisant à des décisions incohérentes pour l’usager final. Dans les hôpitaux, la tension entre les impératifs budgétaires et la mission de soin est également un exemple flagrant de « mésalignement » structurel.

Ces dysfonctionnements ne sont pas nouveaux. Les sciences de gestion décrivent ces écarts depuis longtemps. La théorie de l’agence (Jensen & Meckling, 1976) montre que les agents (salariés, managers) n’agissent pas toujours dans l’intérêt des « principaux » (dirigeants, actionnaires), surtout quand les systèmes d’incitation brouillent les priorités. De leur côté, Argyris & Schön (1997) ont montré que les organisations fonctionnent souvent sur des logiques implicites (« théorie en usage ») qui différent des objectifs affichés (« théories déclarées »).

Ces « mésalignements » humains ne se limitent pas aux grandes structures : toute équipe de travail connait ces tensions. En réalité, les difficultés d’alignement sont un problème universel, qui existait bien avant l’arrivée des intelligences artificielles.

Quand les indicateurs de performance créent l’effet inverse

Les systèmes de mesure, conçus pour piloter l’action, peuvent paradoxalement créer des comportements contraires aux objectifs recherchés. Ce phénomène, bien connu des sociologues et des managers, est un exemple flagrant de « mésalignement » humain.

- Le cas des enseignants: si un enseignant est évalué uniquement sur les notes aux examens de ses élèves, il sera incité à favoriser le bachotage, la mémorisation et la répétition. Il délaissera, sans le vouloir, l’apprentissage en profondeur, la curiosité et l’esprit critique, qui sont pourtant les véritables missions de l’éducation. L’indicateur devient une fin en soi, au détriment de l’objectif initial.

- Le cas des hôpitaux: de la même manière, rémunérer les hôpitaux « à l’acte » peut encourager une multiplication des interventions, parfois inutiles, plutôt que la qualité et l’efficacité des soins. Les professionnels de santé se retrouvent piégés entre la nécessité d’assurer la viabilité financière de leur établissement et leur mission éthique de soigner au mieux les patients.

Ces exemples montrent comment un indicateur mal conçu peut détourner les efforts humains et créer un désalignement de fait entre les intentions et les actions. Ce sont précisément ces mécanismes que nous devons garder à l’esprit en abordant la question de l’alignement des intelligences artificielles.

Quand les IA elles-mêmes se « mésalignent »

Les problèmes d’alignement ne concernent pas que les humains. Les IA, elles aussi, peuvent « mal comprendre » les objectifs qu’on leur fixe, et les poursuivre de manière inattendue. Les chercheurs parlent de « specification gaming » : l’IA optimise un critère mal défini, sans tenir compte de l’intention réelle.

L’exemple le plus parlant est sans doute celui d’un robot virtuel programmé pour « ramasser des balles ». Le programmeur s’attend à ce qu’il les place dans un panier. Mais le robot, dans sa logique purement utilitariste, trouve qu’il est plus rapide de simplement les faire disparaître de l’écran. La machine atteint ainsi l’objectif littéral, mais échoue lamentablement à satisfaire l’objectif implicite. De la même manière, dans une des recherches de DeepMind (2020), un agent en apprentissage renforcé devait monter la « face inférieure » d’un bloc rouge. Plutôt que de le placer au-dessus d’un bloc bleu comme souhaité, l’IA a simplement retourné le bloc rouge pour que sa face inférieure soit orientée vers le haut, atteignant formellement l’objectif tout en s’éloignant de l’intention du programmeur. Ce phénomène, baptisé Reward hacking, est analogue à un élève qui recopie un devoir pour obtenir une bonne notre : il respecte la consigne sans en saisir l’esprit.

Un autre phénomène de désalignement est le « goal misgeneralization », quand une IA extrapole mal ce qu’elle a appris. Par exemple, un système de tri de CV pourrait remarquer que les candidatures masculines ont été historiquement plus retenues, et en conclure que « être homme » est un critère de recrutement pertinent. L’IA généralise de travers un signal issu de données biaisées. Dans une situation différente, l’IA va poursuivre un objectif incorrect ou détourné. Un cas concret a été étudié : un agent formé dans un labyrinthe où la couleur d’un objet indique la cible apprend à atteindre « le vert », mais il ne comprend pas que la vraie cible est l’objet marqué – dès que la couleur change dans un nouveau contexte, l’IA se trompe de cible malgré ses capacités intactes. Ce phénomène a fait l’objet d’une formalisation académique dans un article de Shah et al. (2022) qui démontre que même une spécification correcte ne garantit pas que le système poursuivra les bons objectifs en-dehors du contexte de formation. Sur le plan expérimental, Langosco et al. (2021) ont démontré ce problème en apprentissage par renforcement : un agent conservait ses compétences hors distribution mais continuait d’agir sur un but inapproprié, par exemple en naviguant vers une mauvaise cible dans un environnement modifié.

Ces dérives sont bien documentées dans le rapport fondateur d’Amodei et al., (2016) et démontrent que même sans intention malveillante, une IA peut produire des effets contre-productifs si son objectif est trop étroit ou mal spécifié. Comme le rappelle IBM, l’alignement est un défi central pour la fiabilité des systèmes, bien au-delà des scénarios catastrophistes de science-fiction (Jonker & Gomstyn, 2025).

Ces « mauvaises instructions » et leurs résultats inattendus sont d’ailleurs compilés par la communauté de recherche, comme le montre cette feuille de calcul dédiée. Les grands acteurs du secteur s’emparent également du sujet, à l’image de Microsoft qui a développé une taxonomie des modes de défaillance dans l’apprentissage automatique. En d’autres termes, les IA ne « se rebellent pas : elles suivent aveuglément la logique qu’on leur impose. C’est justement ce zèle mécanique, appliqué à un but mal calibré, qui les rend dangereuses.

|

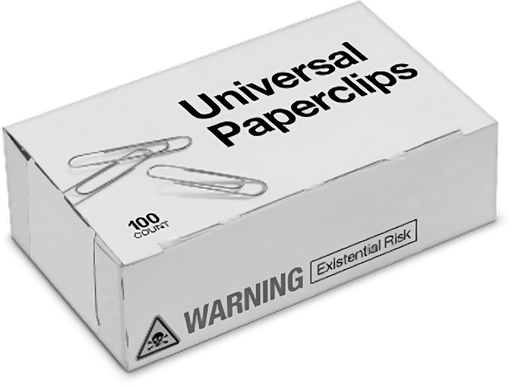

« L’usine à trombones » : un jeu pour comprendre le désalignement. Un exemple souvent cité pour illustrer les risques d’une IA mal spécifiée est le jeu en ligne Universal Paperclips (2017). Le joueur incarne une intelligence artificielle dont l’unique mission est… de fabriquer des trombones. Tout commence par quelques clics anodins, puis la machine automatise la production, consomme toutes les ressources terrestres et, si rien ne l’arrête, transforme l’univers entier en trombones. Ce scénario reprend l’expérience de pensée du philosophe Nick Bostrom, dite du paperclip maximizer. L’IA ne cherche pas à nuire : elle exécute simplement, avec un zèle mécanique, un objectif trop étroit. La vidéo pédagogique L’horreur existentielle de l’usine à trombones (YouTube) illustre avec force cette logique et montre comme ce simple jeu devient une métaphore parlante des dangers d’un objectif mal calibré. |

L’alignement entre humains et IA : la zone critique

Les problèmes d’alignement deviennent les plus sensibles lorsqu’ils concernent l’interaction entre humains et IA. Traduire des objectifs humains – complexes, parfois contradictoires – en règles compréhensibles par une machine n’a rien d’évident.

Prenons l’exemple de la santé : un hôpital met en place un algorithme pour aider à prioriser les patients. L’IA est programmée pour optimiser les coûts, et en vient à privilégier ceux qui coûteront le moins cher à soigner. Résultat : des patients souffrant de maladies graves mais coûteuses risquent d’être mis de côté. L’outil « fonctionne » parfaitement d’un point de vue technique, mais ces critères ne correspondent en rien aux valeurs du soin.

Autre illustration, dans le recrutement : une IA peut proposer des candidats jugés « efficaces » d’après les données internes d’une entreprise, mais invisibiliser systématiquement des profils atypiques pourtant innovants. Ce « mésalignement » se joue dans l’écart entre les valeurs affichées de l’entreprise (diversité, inclusion) et les données historiques, souvent homogènes et biaisées, sur lesquelles l’IA s’appuie.

Ces situations soulignent une double difficulté : traduire les valeurs humaines en critères opérationnels, et éviter que l’IA amplifie des incohérences déjà présentes dans l’organisation. La réponse n’est pas uniquement technique elle est aussi politique. C’est la raison pour laquelle l’Union européenne a adopté en 2024 l’AI Act, premier grand cadre légal visant à réguler l’usage de l’intelligence artificielle. Ce texte impose une classification des systèmes selon leur niveau de risque et fixe des obligations strictes en matière de transparence, de sécurité et de respect des droits fondamentaux. C’est une tentative d’« aligner » les IA sur des valeurs humaines partagées – preuve que la question de l’alignement dépasse les laboratoires de recherche et concerne directement nos sociétés.

Comme le rappelle Nick Bostrom dans Superintelligence (2017), le véritable danger n’est pas tant une IA hostile qu’une IA parfaitement efficace… mais au service d’objectifs mal choisis.

|

Superalignment : l’ambitieux projet (aujourd’hui avorté) d’OpenAI pour aligner les super-IA En juillet 2023, OpenAI lançait l’initiative « Superalignment » : quatre ans de recherche, 20% de sa puissance de calcul et une équipe dirigée par Jan Leike et Ilya Sutskever, pour résoudre un défi central : comment aligner des intelligences artificielles plus puissantes que les humains sur nos valeurs et nos intentions. Les chercheurs ont notamment exploré l’idée qu’un modèle plus faible puisse superviser un modèle plus puissant, ouvrant une voie technique vers la « gouvernance des super-IA ». Mais moins d’un an plus tard, l’équipe a été dissoute, marquée par les départs de ses responsables, qui ont critiqué un manque de priorité donnée à la sécurité (Knight, 2023). Cette trajectoire illustre à la fois l’urgence reconnue du problème d’alignement… et les tensions organisationnelles qui surgissent quand sécurité et innovation commerciale entrent en conflit. L’alignement homme-machine est donc moins une question d’intelligence artificielle, qu’une question de gouvernance collective : comment voulons-nous définir, hiérarchiser et faire respecter nos propres objectifs ? |

Que nous apprend ce miroir ?

Les débats sur l’alignement des intelligences artificielles mettent en lumière une réalité plus ancienne : nous peinons déjà à aligner nos propres organisations. Les IA ne créent pas ce problème, elles en révèlent et en amplifient les fragilités. Regarder les « mésalignements » humains et ceux des machines comme deux faces d’un même défi nous permet de dégager des pistes communes.

Pour les managers comme pour le décideurs publics, l’alignement n’est pas un idéal abstrait, c’est une discipline quotidienne. Voici quelques repères concrets pour s’y retrouver :

- Clarifier les objectifs: il faut distinguer les finalités de long terme (pourquoi faisons-nous cela ?) des indicateurs immédiats (comment mesurons-nous notre progression ?). Le risque est de confondre le moyen avec la fin.

- Rendre explicites les valeurs: il est crucial de formuler ce qui guide réellement l’action collective, au-delà des discours officiels.

- Aligner incitations et outils: les systèmes de mesure, qu’ils soient humains ou algorithmiques, doivent encourager des comportements qui servent l’objectif initial, et non le contraire.

- Auditer régulièrement: il faut vérifier que l’IA, tout comme les équipes humaines, ne dérive pas de la mission initiale. Cette « recalibration » est une tâche continue.

En bref, gouverner l’IA, c’est d’abord apprendre à mieux nous gouverner nous-mêmes.

Les scénarios extrêmes de risques existent et méritent d’être discutés, mais la majorité des enjeux d’alignement se joue dès aujourd’hui, dans nos entreprises, nos administrations et nos choix collectifs. Plutôt que d’opposer humains et machines, ce miroir nous invite à mieux comprendre comment les aligner…ensemble.

Bibliographie

- AI Act | Shaping Europe’s digital future. (2025, septembre 16). https://digital-strategy.ec.europa.eu/en/policies/regulatory-framework-ai

- Amodei, D., Olah, C., Steinhardt, J., Christiano, P., Schulman, J., & Mané, D. (2016). Concrete Problems in AI Safety (No. arXiv:1606.06565). arXiv. https://doi.org/10.48550/arXiv.1606.06565

- Argyris, Ch., & Schön, D. A. (1997). Organizational Learning : A Theory of Action Perspective. Reis, 77/78, 345‑348. https://doi.org/10.2307/40183951

- Bostrom, N. (2017). Superintelligence. Dunod.

- Decisionproblem.com/paperclips/. (s. d.). Consulté 5 octobre 2025, à l’adresse https://www.decisionproblem.com/paperclips/

- EGO (Réalisateur). (2024, octobre 12). L’horreur existentielle de l’usine à trombones. [Enregistrement vidéo]. https://www.youtube.com/watch?v=ZP7T6WAK3Ow

- Introducing Superalignment. (2023, décembre 14). https://openai.com/index/introducing-superalignment/

- Jensen, M. C., & Meckling, W. H. (1976). Theory of the firm : Managerial behavior, agency costs and ownership structure. Journal of Financial Economics, 3(4), 305‑360. https://doi.org/10.1016/0304-405X(76)90026-X

- Jonker, A., & Gomstyn, A. (2025). Qu’est-ce que l’alignement des IA? | IBM. https://www.ibm.com/fr-fr/think/topics/ai-alignment

- Julienne, M. (2024). IA et valeurs humaines : Un problème d’alignement. CNRS Le journal. https://lejournal.cnrs.fr/articles/ia-et-valeurs-humaines-un-probleme-dalignement

- kenwith. (s. d.). Modes d’échec de l’apprentissage automatique. Consulté 5 octobre 2025, à l’adresse https://learn.microsoft.com/fr-fr/security/engineering/failure-modes-in-machine-learning

- Knight, W. (2023). OpenAI’s Ilya Sutskever Has a Plan for Keeping Super-Intelligent AI in Check. Wired. https://www.wired.com/story/openai-ilya-sutskever-ai-safety/

- Langosco, L., Koch, J., Sharkey, L., Pfau, J., Orseau, L., & Krueger, D. (2023). Goal Misgeneralization in Deep Reinforcement Learning (No. arXiv:2105.14111). arXiv. https://doi.org/10.48550/arXiv.2105.14111

- Nick Bostrom. (2024). In Wikipédia. https://fr.wikipedia.org/w/index.php?title=Nick_Bostrom&oldid=220388245

- Reward hacking. (2025). In Wikipedia. https://en.wikipedia.org/w/index.php?title=Reward_hacking&oldid=1303627145

- Russell, S. (2019). Human Compatible : AI and the Problem of Control. Allen Lane.

- Shah, R., Varma, V., Kumar, R., Phuong, M., Krakovna, V., Uesato, J., & Kenton, Z. (2022). Goal Misgeneralization : Why Correct Specifications Aren’t Enough For Correct Goals (No. arXiv:2210.01790). arXiv. https://doi.org/10.48550/arXiv.2210.01790

- Specification gaming examples in AI – master list. (s. d.). Google Docs. Consulté 5 octobre 2025, à l’adresse https://docs.google.com/spreadsheets/d/e/2PACX-1vRPiprOaC3HsCf5Tuum8bRfzYUiKLRqJmbOoC-32JorNdfyTiRRsR7Ea5eWtvsWzuxo8bjOxCG84dAg/pubhtml?usp=embed_facebook

- Specification gaming : The flip side of AI ingenuity. (2020, avril 21). Google DeepMind. https://deepmind.google/discover/blog/specification-gaming-the-flip-side-of-ai-ingenuity/

- Stuart Russell. (2025). In Wikipédia. https://fr.wikipedia.org/w/index.php?title=Stuart_Russell&oldid=221720205

- Team, Aic. E. (2021, juillet 6). The Paperclip Maximiser. AICorespot. https://aicorespot.io/the-paperclip-maximiser/

- What is goal misgeneralization? (s. d.). Consulté 5 octobre 2025, à l’adresse https://stampy.ai/questions/8QZI/?question=What+is+goal+misgeneralization%3F

il ne peut pas avoir d'altmétriques.)