Citation

L'auteur

Philippe JEAN-BAPTISTE

(philippejb@icloud.com) - LEST - Laboratoire d'Économie et de Sociologie du Travail UMR 7317 I CNRS – Aix Marseille Université - ORCID : https://orcid.org/0000-0003-0656-7588

Copyright

Déclaration d'intérêts

Financements

Aperçu

Contenu

Les capacités de reconnaissance visuelle, longtemps perçues comme l’apanage du vivant, sont aujourd’hui reproduites – et parfois surpassées – par des systèmes d’intelligence artificielle. De la reconnaissance faciale à l’analyse d’imagerie médicale, en passant par la classification d’objet, l’IA « voit » désormais avec une vitesse, une précision et une constance qui bouleversent de nombreux secteurs (Lecun et al., 2015; Esteva et al., 2017).

La reconnaissance d’image s’impose comme l’un des champs les plus aboutis de l’IA dite « perceptive », aux croisements de l’apprentissage profond, de la vision par ordinateur, et de la classification supervisée (Goodfellow et al., 2016; Szeliski, 2022).

Derrière les prouesses techniques, cette technologie soulève également des questions managériales : comment articuler la puissance algorithmique avec les compétences humaines d’interprétation ? Quels enjeux éthiques, de responsabilité et de transformation des métiers se cachent derrière la promesse d’une vision automatisée (Eubanks, 2019; Zuboff, 2019) ? Cet article propose un état de l’art des usages de la reconnaissance d’image par l’IA, en explorant à la fois ses fondements techniques, ses cas d’usage, ses limites et ses implications pour les managers.

Comment ça marche ? Fondements techniques de la reconnaissance d’image.

La reconnaissance d’image par l’intelligence artificielle repose principalement sur des techniques de deep learning appliquées à des données visuelles. Le cœur de ces systèmes est constitué de réseaux de neurones convolutifs (CNN – Convolutional Neural Networks), particulièrement efficaces pour extraire des caractéristiques visuelles à différentes échelles (LeCun et al., 1998; Krizhevsky et al., 2017).

Le processus commence par l’entrainement d’un modèle sur des bases de données d’images massives, telles qu’ImageNet (Deng et al., 2009), annotées manuellement pour permettre une supervision de l’apprentissage. Le système apprend à identifier des motifs visuels, à repérer des structures (bords, textures, formes) et à les combiner progressivement pour reconnaître des objets complexes, des visages ou des scènes entières.

|

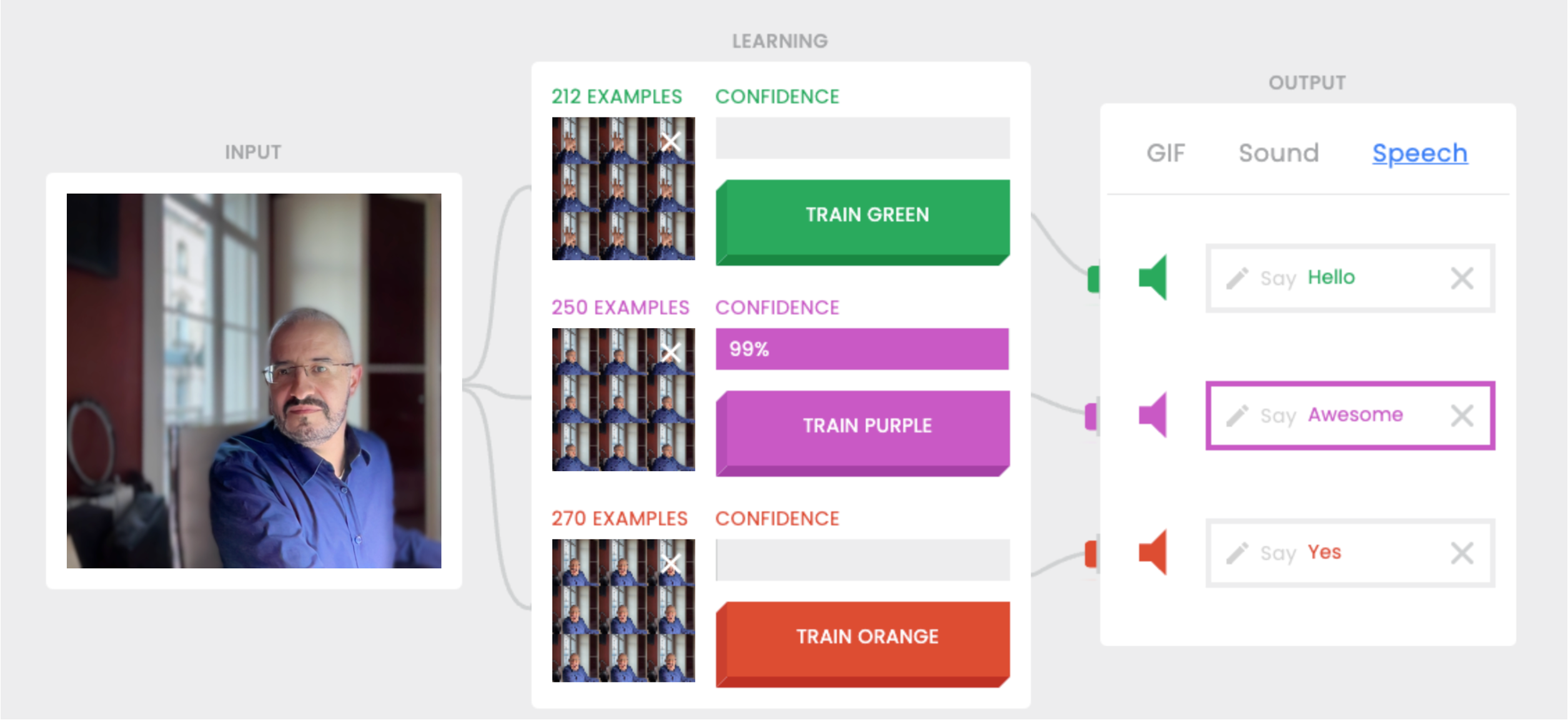

Apprendre en jouant avec l’IA : Teachable Machine Pour expérimenter la reconnaissance d’image sans compétences en programmation, Teachable Machine de Google offre une interface intuitive. Cet outil premet de créer un modèle d’IA personnalisé en quelques minutes : il suffit de fournir des exemples via webcam ou fichiers, puis de lancer l’entraînement. Le modèle peut ensuite être testé en temps réel et exporté pour des projets web ou mobiles. c’est un excellent support pédagogique pour comprendre les bases de l’apprentissage supervisé et des réseaux neuronaux convolutifs. |

L’arrivée de l’apprentissage profond a permis une rupture qualitative : les performances des systèmes de vision automatisée ont largement dépassé celles des approches classiques fondées sur la détection manuelle de caractéristiques (Szeliski, 2022). Des architectures comme AlexNet, VGG, ResNet ou EfficienNet ont ensuite fait progresser la précision, la vitesse d’inférence et la robustesse des modèles.

Aujourd’hui, les applications s’étendent de la vidéosurveillance intelligente à la reconnaissance d’émotions, en passant par le diagnostic médical automatisé, les véhicules autonomes ou encore le tri de produits en logistique. Cependant, malgré ces avancées, ces modèles restent sensibles au contexte : leur efficacité dépend fortement de la qualité des données d’entrainement, de la clarté des images, et de l’absence de biais visuels.

Cas d’usage : quand les machines « voient » pour décider

La reconnaissance d’image a investi une grande variété de secteurs, transformant à la fois les fonctions techniques, les services aux usagers, et les modalités de travail. Son efficacité repose sur l’automatisation de tâches visuelles répétitives ou complexes, avec des niveaux de performance qui dépassent parfois ceux des humains dans des contextes spécifiques.

Sécurité et contrôle : surveillance automatisée et biométrie

Dans les transports publics, les aéroports, ou les bâtiments sensibles, la reconnaissance faciale est désormais utilisée pour contrôler l’accès, identifier des personnes recherchées ou détecter des comportements suspects. En Chine, plusieurs villes ont équipé leurs espaces publics de systèmes combinant IA et caméras haute définition pour repérer des individus dans la foule. Ce type d’usage alimente des débats sur les libertés publiques, la vie privée et la surveillance de masse (Zuboff, 2019).

|

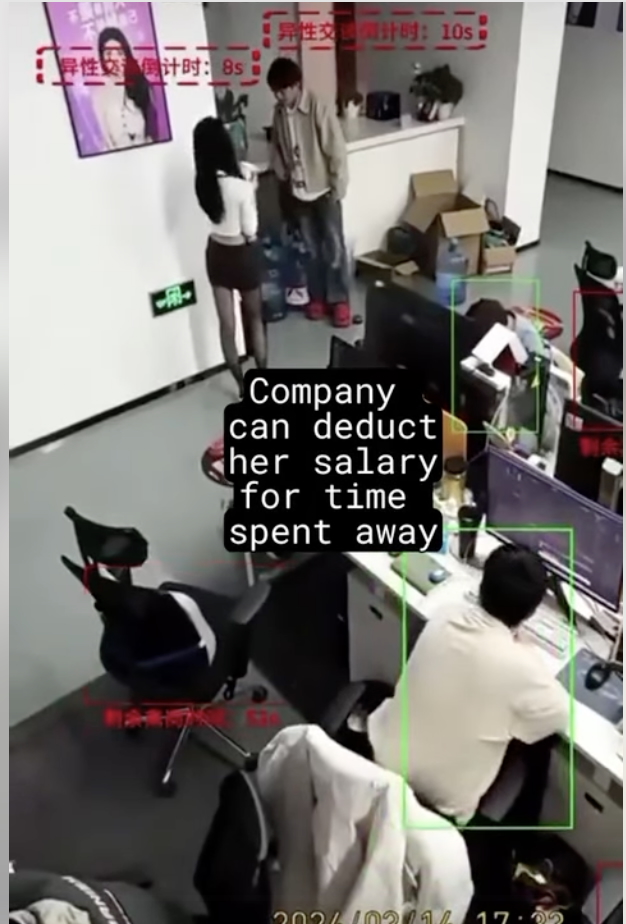

Quand l’IA surveille les salariés : entre productivité et éthique Une vidéo virale a récemment mis en lumière l’utilisation de l’IA pour surveiller la productivité des employés. Dans cette séquence, un système d’IA détecte si un salarié est à son poste et déclenche un compte à rebours dès qu’il s’absente, pouvant entraîner des sanctions ? Cette pratique soulève des questions éthiques sur la surveillance au travail et l’équilibre entre efficacité et respect de la vie privée. Des experts mettent en garde contre les effets négatifs de telles méthodes sur le moral et la confiance des employés.

|

Industrie et logistique : automatisation du contrôle qualité

Les chaînes de production font un usage croissant de la reconnaissance d’image pour le tri, le contrôle qualité ou la détection d’anomalies (rayures, défauts d’assemblage, pièces manquantes). L’IA permet ici un gain de temps, une réduction des erreurs humaines, et une optimisation continue des processus, notamment via l’apprentissage en ligne.

|

L’IA au service du tri des déchets : l’exemple de Greyparrot La start-up britannique Greyparrot a développé un système d’IA embarquée destiné à améliorer le tri des déchets dans les centres de recyclage. Grâce à des caméras intelligentes et des algorithmes de visio par ordinateur, leur technologie analyse en temps réel les flux de déchets sur les tapis roulants, identifiant et classifiant les matériaux selon leur nature (plastique, métal, papier, etc.) et leur marque. Cette solution permet non seulement d’optimiser le tri et de réduire les erreurs, mais aussi de fournir des données précieuses aux gestionnaires de déchets et aux producteurs d’emballages pour améliorer la conception des produits et la chaîne de recyclage.

|

Santé : aide au diagnostic médical

L’analyse d’imagerie médicale (radiographies, IRM, scanners) est un champ d’application prioritaire. Des modèles d’IA entraînés sur des millions d’images peuvent détecter certains types de cancers ou anomalies plus précocement que des professionnels expérimentés, notamment dans les domaines de l’ophtalmologie, de la dermatologie ou l’oncologie. Cependant, ces systèmes ne remplacent pas l’expertise médicale : ils interviennent comme assistants, apportant des secondes lectures ou aidant à prioriser les cas (Topol, 2019).

|

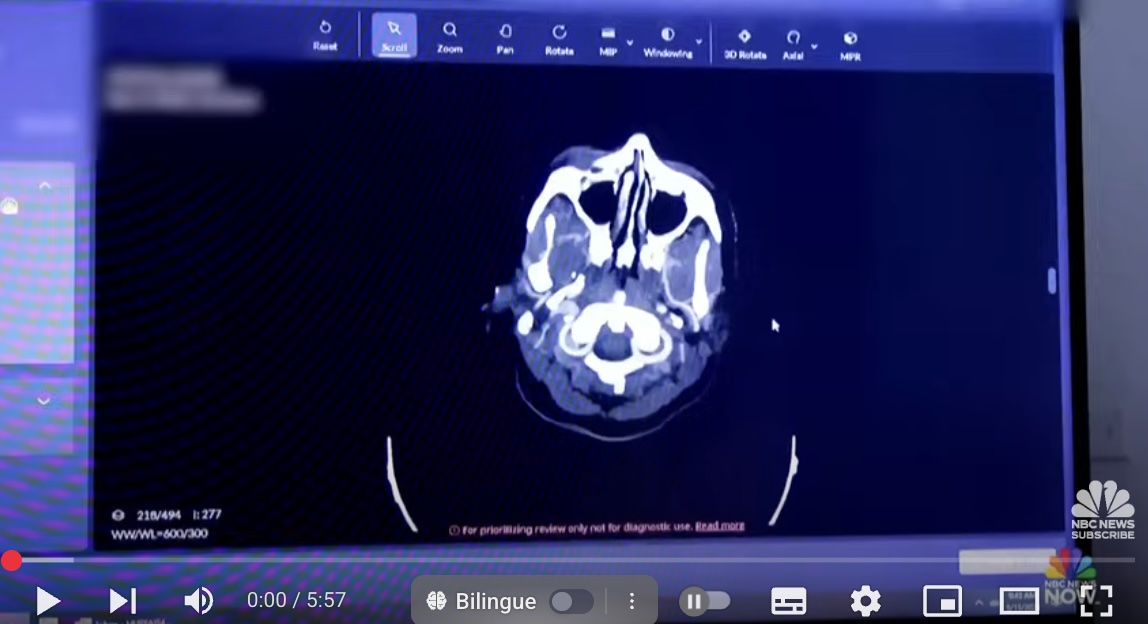

L’IA au service du diagnostic médical : l’exemple de l’imagerie médicale L’intelligence artificielle (IA) révolutionne le domaine de l’imagerie médicale en aidant les médecins à diagnostiquer plus rapidement et avec une précision accrue. Par exemple, des systèmes d’IA sont désormais capables d’analyser des radiographies, des IRM ou des scanners pour détecter des anomalies telles que des tumeurs ou des lésions, parfois même avant qu’elles ne soient visibles à l’œil humain. Cette technologie permet non seulement de gagner du temps, mais aussi de réduire les erreurs de diagnostic, offrant ainsi une meilleure prise en charge des patients. Une illustration concrète de cette avancée est présentée dans cette vidéo :

|

Commerce et distribution : personnalisation et expérience client

Certaines enseignes utilisent la reconnaissance faciale pour analyser les comportements en magasin, détecter les émotions, ou proposer des contenus personnalisés en fonction de l’âge ou du sexe apparent des visiteurs. Ces pratiques visent à améliorer l’expérience client, mais suscitent aussi des critiques sur la manipulation des affects et la captation de données sans consentement éclaire.

|

Personnalisation en magasin : la reconnaissance faciale au service de l’expérience client Dans le secteur du commerce de détail, la reconnaissance faciale est utilisée pour analyser les comportements des clients en magasin, détecter leurs émotions et proposer des contenus personnalisés en fonction de leur âge ou de leur sexe apparent. par exemple, des enseignes intègrent cette technologie pour adapter les publicités affichées ou pour reconnaître les clients fidèles et leur offrir des promotions ciblées.

|

Ressources humaines : surveillance du travail et sélection des candidats

Dans certains cas controversés, la reconnaissance faciale est utilisée pour suivre la présence et l’attention des salariés (par exemple, via des webcams pendant le télétravail), ou pour analyser les expressions faciales lors d’entretiens d’embauche. ces usages reposent sur des hypothèses contestées (corrélation entre expression faciale et émotion réelle, entre attention visuelle et engagement), et soulèvent des risques éthiques majeurs.

|

Surveillance des employés : l’IA dans les ressources humaines Dans le domaine des ressources humaines, certaines entreprises utilisent la reconnaissance faciale pour surveiller la présence et l’attention des salariés, notamment via des webcams pendant le télétravail, ou pour analyser les expressions faciales lors d’entretiens d’embauche. Ces pratiques soulèvent des questions éthiques, notamment en ce qui concerne la vie privée des employés et la fiabilité des analyses émotionnelles. Une illustration de cette utilisation est présentée dans la vidéo suivante :

|

Les limites critiques de la reconnaissance d’image

Une précision encore conditionnelle

Malgré les avancées spectaculaires, les systèmes de reconnaissance d’image demeurent sensibles à de nombreux facteurs environnementaux : qualité de l’image, angle de prise de vue, luminosité ambiante, diversité des expressions faciales ou encore conditions de captation. La précision peut rapidement chuter dans des environnements non idéaux ou non représentés dans les données d’entrainement, entraînant des erreurs parfois graves, notamment dans les secteurs sensibles comme la santé ou la sécurité.

Barocas, Hardt et Narayanan (2023) soulignent que la performance de ces modèles repose sur une généralisation encore imparfaite, particulièrement lorsque les conditions réelles divergent des situations apprises.

Des biais d’entrainement qui amplifient les inégalités

La majorité des bases de données d’entrainement – comme ImageNet ou COCO – sont issues de corpus occidentaux, souvent biaisés du point de vue géographique, socio-économique ou ethnique. Ce biais de représentation induit des performances inégales selon les groupes d’individus, avec des taux d’erreur plus élevés pour les visages non blancs, les femmes, ou les personnes âgées. Kate Crawford (2021), dans Atlas of AI, démontre que ces biais ne sont pas accidentels : ils sont structurels, car intégrés dès la collecte des données, et ils reproduisent les hiérarchies du monde social dans les systèmes automatisés.

Une surveillance de plus en plus opaque et intrusive

L’usage de la reconnaissance faciale dans les espaces publics, les écoles ou les entreprises s’est largement banalisé. Or, cette normalisation d’une technologie invasive soulève des inquiétudes majeures : peu d’utilisateurs sont informés de son activation, encore moins de son mode de fonctionnement. Cette surveillance automatisée échappe à tout contrôle démocratique, renforçant ce que Shoshana Zuboff (2019) qualifie de « capitalisme de surveillance », où les données comportementales deviennent une ressource exploitable à des fins économiques et sécuritaires. Cette analyse prolonge le diagnostic déjà formulé par Gilles Deleuze (1990), dans son Post-scriptum sur les sociétés de contrôle, où les technologies de traçage deviennent des outils de pouvoir diffus, intégrés au quotidien.

Une légitimité sociale contestée

Dans plusieurs pays européens, des ONG et des collectifs de chercheurs appellent à interdire certaines applications de reconnaissance faciale, notamment l’analyse automatique des émotions en contexte professionnel. Ces pratiques sont fondées sur des hypothèses contestées (corrélation directe entre expressions faciales et émotions authentiques) et peuvent conduire à des formes de surveillance disproportionnées. De nombreux travaux montrent que cette reconnaissance émotionnelle repose sur des bases scientifiques fragiles, pose des problèmes de consentement éclairé, et appelle à une régulation urgente pour prévenir les dérives éthiques et psychosociales.

Perspectives pour les managers

Alors que la reconnaissance d’image devient un levier technologique stratégique dans de nombreux secteurs, son intégration dans les environnements de travail soulève des enjeux spécifiques pour les managers. Loin d’être de simples utilisateurs passifs, ces derniers jouent un rôle clé dans l’appropriation, l’encadrement et la régulation des usages de ces outils.

Comprendre les capacités réelles et les limites

Il ne suffit pas de s’émerveiller devant la puissance d’un modèle : encore faut-il savoir ce qu’il peut – et ne peut pas – faire. Les managers doivent développer une culture minimale des systèmes de visio artificielle, afin d’éviter à la fois les surestimations (illusion d’infaillibilité) et les sous-utilisations par crainte ou méconnaissance. Cela suppose une sensibilisation aux biais algorithmiques, aux marges d’erreur, mais aussi aux conditions concrètes d’usage.

Comme le soulignent Brynjolfddon (2022), l’enjeu central n’est pas de substituer l’humain à l’intelligence artificielle, mais de concevoir des systèmes qui amplifient les capacités humaines. Cela suppose que les managers maîtrisent à la fois les fondements de ces technologies et les conditions de leur usage légitime, en particulier dans les environnements à forte densité relationnelle.

Arbitrer entre performance et éthique

De nombreuses applications de la reconnaissance visuelle – comme ma détection d’émotions ou la surveillance de la productivité – peuvent générer des tensions éthiques fortes. Les managers sont en première ligne pour arbitrer entre efficacité opérationnelle et respect des droits fondamentaux. Cela implique souvent d’inventer des usages responsables, en co-construction avec les équipes, et d’assumer une fonction de « filtre éthique » face à la pression technologique.

Boutin, Lévêque et Desmoulin-Canselier (2023) rappellent que ces dispositifs soulèvent des questions fondamentales de consentement, de proportionnalité, et de gouvernance. Leur usage en entreprise exige donc une vigilance particulière et une régulation rigoureuse, portée au plus près des pratiques managériales.

Préparer les collectifs à une hybridation raisonnée

L’enjeu n’est pas de remplacer l’humain, mais de construire une nouvelle forme de coopération entre les travailleurs et les systèmes automatisés. Dans cette perspective, le manager devient un chef d’orchestre de l’hybridation, chargé de combiner intelligemment l’intuition humaine, l’intelligence émotionnelle, et la puissance de traitement des IA.

Une étude du McKinsey Global institute (Bughin & Hazan, 2018) souligne que les tâches mobilisant des compétences sociales, émotionnelles et cognitives complexes résistent le plus à l’automatisation. Cela renforce le rôle des managers comme médiateurs des interactions, garants du sens et porteurs d’une régulation éthique.

Conclusion – Voir n’est pas comprendre

La reconnaissance d’image, emblématique des progrès spectaculaires de l’intelligence artificielle, illustre à la fois les promesses et les limites de l’automatisation contemporaine. Capable d’identifier des visages, des objets, des comportements ou des émotions à une vitesse inégalée, cette technologie transforme des pans entiers de l’économie : industrie, santé, sécurité, distribution, enseignement ou encore ressources humaines.

Mais voir n’est pas comprendre. L’IA, même sophistiquée, ne dispose d’aucune conscience de ce qu’elle « perçoit ». Elle ne contextualise pas, ne ressent pas, n’anticipent pas les conséquences sociales, politiques ou symboliques de ses classifications. Elle repère des corrélations, mais ignore les causes. Elle détecte des formes, mais ne saisit pas les intentions.

Dans ce contexte, les managers ont un rôle stratégique à jouer. Ils ne peuvent se contenter d’utiliser l’IA comme un outil neutre. ils doivent en devenir les architectes responsables, capables de comprendre son fonctionnement, de questionner ses usages, et de négocier son intégration dans les dynamiques humaines de leurs organisations.

Ce premier volet ouvre ainsi une série d’articles visant à explorer les différents domaines d’application de l’IA. Chacun de ces domaines soulève des enjeux spécifiques, mais appelle une même posture : celle d’un pilotage réflexif et éthique de la technologie, au service d’une performance durable et d’une responsabilité augmentée.

Bibliographie

- Barocas, S., Hardt, M., & Narayanan, A. (2023). Fairness and machine learning : Limitations and opportunities (The MIT Press). The MIT Press.

- Boutin, A., Lévêque, L., & Desmoulin-Canselier, S. (2023). On Legal and Ethical Challenges of Automatic Facial Expression Recognition : An Exploratory Study. Proceedings of the 2023 ACM International Conference on Interactive Media Experiences, 226‑229. https://doi.org/10.1145/3573381.3597217

- Brynjolfsson, E. (2022). The Turing Trap : The Promise & Peril of Human-Like Artificial Intelligence (Version 1). arXiv. https://doi.org/10.48550/ARXIV.2201.04200

- Bughin, J., Seong, J., Manyika, J., Chui, M., & Joshi, R. (18). Modeling the global economic impact of AI | McKinsey. https://www.mckinsey.com/featured-insights/artificial-intelligence/notes-from-the-ai-frontier-modeling-the-impact-of-ai-on-the-world-economy

- Crawford, K. (2021). Atlas of AI : Power, politics, and the planetary costs of artificial intelligence. Yale University Press.

- Deleuze, G. (1990). Post-scriptum sur les sociétés de contrôle. https://infokiosques.net/spip.php?article214

- Deng, J., Dong, W., Socher, R., Li, L.-J., Li, K., & Fei-Fei, L. (2009). ImageNet : A large-scale hierarchical image database. 2009 IEEE Conference on Computer Vision and Pattern Recognition, 248‑255. https://doi.org/10.1109/CVPR.2009.5206848

- Esteva, A., Kuprel, B., Novoa, R. A., Ko, J., Swetter, S. M., Blau, H. M., & Thrun, S. (2017). Dermatologist-level classification of skin cancer with deep neural networks. Nature, 542(7639), 115‑118. https://doi.org/10.1038/nature21056

- Eubanks, V. (2019). Automating inequality : How high-tech tools profile, police, and punish the poor (First Picador edition). Picador St. Martin’s Press.

- Goodfellow, I., Bengio, Y., & Courville, A. (2016). Deep learning. The MIT press.

- Krizhevsky, A., Sutskever, I., & Hinton, G. E. (2017). ImageNet classification with deep convolutional neural networks. Commun. ACM, 60(6), 84‑90. https://doi.org/10.1145/3065386

- LeCun, Y., Bengio, Y., & Hinton, G. (2015). Deep learning. Nature, 521(7553), 436‑444. https://doi.org/10.1038/nature14539

- Lecun, Y., Bottou, L., Bengio, Y., & Haffner, P. (1998). Gradient-based learning applied to document recognition. Proceedings of the IEEE, 86(11), 2278‑2324. https://doi.org/10.1109/5.726791

- Szeliski, R. (2022). Computer Vision : Algorithms and Applications. Springer International Publishing. https://doi.org/10.1007/978-3-030-34372-9

- Topol, E. (2019). Deep Medicine : How Artificial Intelligence Can Make Healthcare Human Again. Basic Books.

- Zuboff, S. (2019). The age of surveillance capitalism : The fight for a human future at the new frontier of power (First edition). PublicAffairs.

il ne peut pas avoir d'altmétriques.)