Citation

L'auteur

Sabrina ZAÏDI-CHTOUROU

(szaidichtourou@univ-catholyon.fr) - ESDES – Université Catholique de Lyon

Copyright

Déclaration d'intérêts

Financements

Aperçu

Contenu

Alors que le volume de données numériques échangées ne cesse d’augmenter dans les entreprises et que le sujet central demeure l’exploitation de cette surabondance d’informations, la quantité d’informations disponible par les décideurs marketing n’est que rarement discutée. Faut-il indubitablement considérer toutes les données disponibles ? Les entreprises se focalisent sur la recherche de moyens pour traiter l’ensemble des informations disponibles, sans jamais remettre en cause l’importance de cette quantité croissante d’informations dans la prise de décision et par conséquent sur les résultats de l’entreprise.

Tandis que l’étude de McAfee et Brynjolfsson (2012) met en évidence la difficulté que rencontrent les directions marketing pour installer le phénomène de la « Data Marketing » dans les priorités, le cabinet McKinsey avait dès lors annoncé dans un rapport de 2011 que le traitement systématique des quantités incommensurables de données confinées dans les entreprises doit être considéré comme le chantier le plus prometteur de ces prochaines années. L’abondance de données est devenue une réalité qui croît de manière exponentielle : ce mouvement qui s’accélère est devenu une tendance lourde de notre société, qui impacte les décisions marketing comme en témoignent les nombreux articles et numéros spéciaux publiés récemment sur le Big data dans la littérature en Sciences de Gestion dans le domaine du marketing (Sivarajah et al., 2017; Chintagunta et al., 2016; Hofacker et al., 2016; Skiera, 2016). Il est donc nécessaire d’établir une relation entre l’utilité des données recueillies dans les Systèmes d’Information Marketing (SIM) et les conséquences du traitement informationnel de ces données au niveau organisationnel. Pour traiter et faire face à l’accroissement du flux externe et interne de l’information et pour améliorer sa qualité, les entreprises devront tirer profit des opportunités offertes par les systèmes d’information et par les technologies de l’information. Les responsables marketing doivent être de plus en plus sensibles à la « data » au risque de manquer de discernement et de se sentir submergés par la volonté de traiter toutes les informations disponibles. Les dangers de la surexploitation de ces données ont pour conséquence des actions opportunistes, décidées au fur et à mesure des dernières retombées (McAfee et Brynjolfsson, 2012). Nous pouvons alors largement nous demander si la quantité d’information est un critère déterminant dans la prise de décision et par conséquent sur les résultats de l’entreprise. La relation entre des informations et la prise de décisions est un domaine complexe qui a été au centre de nombreuses recherches depuis plusieurs années. Plus récemment, les chercheurs ont mis en évidence une relation entre la qualité de l’information et la qualité dans la prise de décisions qui présente des conséquences sur la stratégie de l’entreprise.

Cet article pose la question de la qualité des décisions prises à partir d’importants volumes de données. L’intérêt de cette recherche réside dans l’explication de la relation entre la gestion de l’utilité de l’information dont l’une des composantes est la quantité appropriée d’information dans un Système d’Information Marketing (SIM) et la performance de l’entreprise. Une étude empirique menée auprès de 107 responsables marketing et systèmes d’information met en évidence que la variable « quantité » de l’information n’a aucune incidence sur l’amélioration des décisions marketing bien que l’attention portée à l’amélioration de l’utilité de l’information composées de trois variables « quantité, pertinence, interprétation » est identifiée comme une variable explicative significative de meilleurs résultats dans l’organisation. Notre réflexion se poursuivra sur les éventuels atouts des responsables marketing pour gérer la surabondance inévitable d’informations en se concentrant sur les facteurs « pertinence » (marketing automation, data analyse, data driven marketing) et « interprétation » (data visualisation).

Cadre contextuel

Des données volumineuses

Pour comprendre ce que sont les Big data et leur rôle dans la prise de décision marketing, il faut d’abord comprendre pourquoi nous avons des données volumineuses et comment elles sont créés. Comme certains auteurs le soulignent (Sivarajah et al. 2017, p. 265), le concept de « Big » est difficile à cerner, en partie parce que ce qui peut sembler « Big » aujourd’hui sera qualifié de routinier dans un avenir proche, au fur et à mesure que la puissance de calcul avance.

Les données volumineuses sont souvent définies communément par les « 3V » : de grands volumes de données générées à grande vitesse par une variété de sources. Sivarajah et al. (2017) proposent une liste élargie des « V », en ajoutant la véracité, la variabilité, la visualisation et la valeur. Hofacker et al. (2016) ajoutent la notion de volatilité à cette liste.

La perplexité des services marketing face au traitement de l’information

Les compétences des décideurs marketing et les ressources technologiques nécessitent des aménagements car le big data va permettre aux managers une connaissance et une mesure bien plus radicale de leur activité et ainsi transformer cette connaissance en une amélioration de la prise de décision et de la performance (McAfee et Brynjolfsson, 2012).

Les décideurs marketing ont-ils perçu ou anticipé les dangers de la surexploitation des données ? C’est la question que nous pouvons nous poser alors que la « donnée » reste sous-utilisée dans la prise de décision marketing.

Dans la fin des années 1990, la mise en place de projets CRM se soldait fréquemment par un échec. Les experts de la donnée promettaient alors des résultats impressionnants si l’entreprise mettait en place des systèmes d’information capables de recueillir des volumes de données sur les clients toujours plus grands. Les résultats promis sur la performance furent lents à se présenter car les systèmes sont restés obstinément déconnectés de la manière dont les managers prenaient des décisions et cet ajout supplémentaire de données à traiter complexifiait grandement la prise de décision (Barton et Court, 2012).

Le big data résonne comme une nouvelle perspective d’amélioration de la connaissance client. Or, les différents formats de données ne sont pas toujours simples à appréhender et les managers ne savent pas toujours comment les informations peuvent être utilisées dans la prise de décisions. La créativité prend alors place pour appréhender de nouvelles données externes (Barton et Court, 2012) laissant entrevoir une part de subjectivité dans les décisions.

Quantité des données et mesure de la qualité de l’information

Durant ces trente dernières années, les chercheurs ont exploré une multitude de manières de conceptualiser la qualité des données. Gallagher (1974) a considéré des facteurs tels que l’utilité, l’attraction, le niveau de signification et la pertinence, entre autres, comme déterminants de la valeur des systèmes d’information. Halloran et al. (1978) se sont concentrés sur l’exactitude, la pertinence, la perfection, la récupération, la sécurité d’accès et l’opportunité. Ils ont indiqué une échelle de mesure pour chacune d’elles en termes de système global. D’autres travaux plus récents montrent l’impact de la qualité de l’information sur la performance de la chaîne logistique à travers des dimensions telles que l’utilité, l’exactitude, la complétude ou encore la fiabilité (Hartono et al., 2010). Nous choisissons en ce qui concerne la notion de qualité, une perspective fondée sur les perceptions des utilisateurs, très utilisée dans la recherche en Système d’information et qui tient compte de la notion de quantité de l’information. Nous définissons alors la qualité de l’information en suivant deux orientations complémentaires.

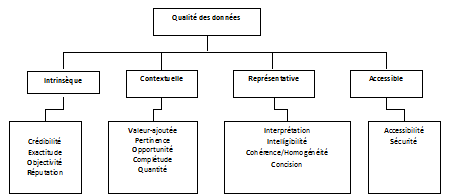

Un modèle cohérent de la qualité des données

Ce n’est que vers le milieu des années 1990 que la recherche sur la qualité de l’information a commencé à fusionner autour d’un cadre commun. En particulier, Wang et al. (1995) ont proposé un cadre dérivé d’ISO 9000 pour classer par catégorie la recherche sur la qualité de données. Ils ont montré une analogie entre la fabrication des produits et le traitement des données. En effet, les systèmes d’information sont considérés comme analogues aux systèmes de fabrication. Les données sont alors considérées comme étant des matières premières, et les données traitées, parfois désignées sous le nom d’information, sont les produits finis. Dans ce modèle, le stockage des données est comparable au stockage de marchandise. Le concept ISO 9000 « Description et Conception » (Wang et al., 1995) traduit la nécessité d’indiquer différents aspects de la qualité des données, tels que des critères d’acceptation et de rejet, conformes à la politique de gestion et soumis à des processus de gestion. Wang et al. (1995) remarquent que l’utilisation du terme « donnée produit » (data product) souligne le fait que les données produites ont la valeur qui est transférée aux clients, qu’ils soient internes ou externes à l’organisation. Cette perspective est devenue peu après l’une des forces majeures menée par Wang et Strong (1996) « pour développer un cadre qui propose les aspects de la qualité des données qui sont importants pour les consommateurs de données ». Ils ont synthétisé leurs résultats comme suit : la qualité intrinsèque des données indique que les données ont la qualité qui leur est propre. La qualité contextuelle accentue la condition selon laquelle des données doivent être considérées dans le contexte d’une tâche précise. La qualité représentative et la qualité accessible des données soulignent l’importance du rôle des systèmes. Les auteurs résument les conséquences de leur étude de la manière suivante : « Ces résultats sont conformes à notre perception selon laquelle les données de haute qualité devraient être intrinsèquement bonnes, contextuellement appropriées à une tâche précise, clairement représentées et accessibles aux consommateurs de données. La figure 1 décrit le modèle de la qualité des données de Wang et Strong (1996) comme un concept multidimensionnel.

Figure 1 – Traduction du « Construit multidimensionnel de la qualité des données » (Wang et Strong, 1996)

Un modèle sur la performance des produits et des services

Kahn et al. (2002) ont reconnu que les modèles conceptuels dominants ont traité l’information comme un produit, pourtant ils notent qu’elle « peut également être conceptualisée comme un service » (Kahn et al., 2002, p.186). Un service, à la différence d’un produit, « est périssable, car il ne peut pas être conservé ; il est produit et consommé simultanément ». En plus d’identifier les aspects de service de la qualité de l’information, ils identifient d’autres manières de caractériser la qualité, deux d’entre elles ont été retenues pour répondre à leurs objectifs : « se conformer aux instructions / spécifications du producteur de l’information » et « satisfaire les attentes du consommateur de l’information ». En combinant ces deux définitions avec les aspects « produit et service » de la qualité de l’information, ils ont développé un prolongement significatif du modèle de Wang et Strong (1996), intitulé « Modèle de la performance des produits et des services pour la qualité de l’information » (Product and service performance model for information quality) (PSP/IQ) (Kahn et al., 2002, p.184). Le modèle de PSP/IQ est représenté sous la forme d’un tableau à deux lignes et deux colonnes (tableau 1).

Tableau 1 – Le modèle PSP/IQ (Kahn et al., 2002) (Traduction)

| Conforme aux instructions | Répond aux attentes | |

| Produit | Justesse Erreur Concision Complétude Cohérence/Homogénéité |

Utilité Quantité Pertinence Intelligibilité Interprétation Objectivité |

| Service | Fiabilité Opportunité Sécurité |

Utilisabilité Crédibilité Accessibilité Facilité d’utilisation Réputation Valeur ajoutée |

Mirani et Lederer (1998) ont développé un outil permettant de mesurer un ensemble de résultats organisationnels dans chacune des catégories illustrées sur la figure 1 en utilisant de deux à quatre items d’étude par catégorie. Une observation plus étroite des items qui mesurent les avantages informationnels indique que chaque item reflète une ou plusieurs des dimensions identifiées par l’analyse factorielle de Wang et Strong (1996).

Lee et al. (2002) ont développé une méthodologie utile pour identifier des aspects de la qualité de l’information qui nécessitent une attention particulière. Leur méthodologie est développée à partir de l’utilisation du modèle de PSP/IQ pour établir des tests de performance. Elle inclut deux formes d’analyse de l’écart. La première est désignée sous le nom de « Benchmarking Gap Analysis» (Lee et al., 2002, p.140).

Tableau 2 – Comparaison des avantages informationnels de Mirani et Lederer (1998), des dimensions de Wang et Strong (1996) et des niveaux du modèle PSP/IQ de Lee et al. (2002) pour la dimension « Utilité de l’information »

| Mirani and Lederer (1998) | Wang and Strong (1996) | Lee et al. (2002) |

| Qualité de l’information : Améliorer l’information destinée au contrôle opérationnel | Pertinence (Contextuelle) | Utilité |

Méthodologie de l’étude quantitative

Présentation du modèle de l’étude

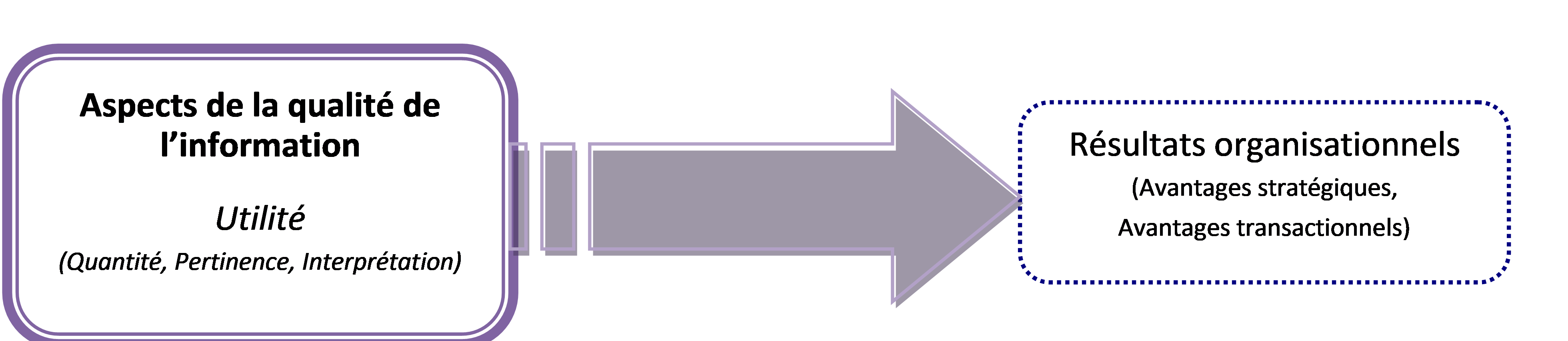

Le modèle (figure 2) identifie un aspect spécifique de la qualité de l’information : « l’utilité » ainsi que les résultats organisationnels qui regroupent l’avantage stratégique et l’avantage transactionnel. Chacun de ces items constitue une variable dans le modèle conceptuel.

Figure 2 – Relation entre l’utilité de la qualité de l’information et les résultats organisationnels

L’objectif est de mesurer les effets des perceptions des utilisateurs et des décideurs des SIM sur l’importance, l’état actuel et les résultats organisationnels de l’amélioration de l’utilité de l’information de leur organisation. L’analyse des données mesure la relation entre la perception des utilisateurs à l’égard de l’utilité de l’information au niveau du SIM et la perception des avantages stratégiques et transactionnels. Les avantages stratégiques incluent l’avantage concurrentiel, l’alignement entre l’activité et les systèmes d’information et l’amélioration de la relation client. Les avantages transactionnels comprennent l’efficacité de la communication, l’efficacité dans le développement des systèmes et l’efficacité de l’activité (Mirani et Lederer, 1998). Nous avons émis l’hypothèse que l’amélioration dans divers aspects de l’utilité de l’information affecterait positivement ces résultats stratégiques et transactionnels. Deux hypothèses sont proposées :

- H1 : Des améliorations dans l’utilité de l’information sont associées à des avantages stratégiques accrus.

- H2 : Des améliorations dans l’utilité de l’information sont associées/liées à des avantages transactionnels accrus.

Mesure des variables

Deux types de variables ont été opérationnalisées pour cette étude : les variables indépendantes mesurant divers aspects de l’utilité de l’information, les variables dépendantes mesurant les résultats organisationnels stratégiques et transactionnels au niveau de la fonction marketing et de l’organisation toute entière. Les variables indépendantes pour mesurer la qualité de l’information ont été opérationnalisées sur deux niveaux : le niveau dimension et le niveau PSP/IQ. Le niveau dimension a été mesuré directement en employant les items de l’instrument d’évaluation de la qualité de l’information (IQA) (Lee et al., 2002). Les variables dépendantes pour cette étude correspondent à celles employées pour mesurer les résultats organisationnels. Les dimensions « avantages stratégiques » et « avantages transactionnels » ont été mesurées en employant les items de l’instrument développé par Mirani et Lederer (1998) « Les avantages organisationnels des projets SI ». Des questions filtres ont été utilisées pour classer les personnes interrogées en fonction de leur qualité à participer à cette étude. L’échantillon est composé de participants qui interagissent régulièrement avec des informations liées à la fonction marketing. Des questions de classification ont été incluses dans cette enquête pour identifier la fonction du participant, ainsi que des informations sur l’organisation du participant, y compris le secteur d’activité et la taille de l’entreprise.

Échantillon

Les données ont été recueillies grâce à une enquête en ligne menée auprès de répondants associés à la fonction Marketing. Au total 552 individus ont été invités par téléphone à participer à une enquête basée sur Internet et 107 réponses ont été reçues. Ces données ont été évaluées par une combinaison d’analyses de régressions multiples. En nous basant sur une analyse uni-variée, nous avons déterminé que 7 cas devaient être retirés à cause de valeurs manquantes ou aberrantes. L’échantillon était ainsi ramené à 100 cas utiles pour l’analyse. 63% des répondants travaillent dans une entreprise de services et 23% dans une entreprise industrielle. Une variable « Autres » a été créée pour regrouper les agences gouvernementales, la santé et l’éducation qui représentent 14% de l’échantillon.

Des différences selon les secteurs

Pour déterminer s’il y avait des différences significatives dans les réponses selon les différents secteurs d’activité, une analyse de la variance (ANOVA) a alors été réalisée. Des items se sont avérés présenter des différences significatives à p = 0,01. Une étude plus minutieuse a indiqué un modèle systématique dans lequel les répondants « autres secteurs d’activité » ont évalué l’utilité de l’information dans leurs systèmes de manière plus élevée que les répondants appartenant à une entreprise de services qui ont eux même évalué l’utilité de manière plus élevée que les répondants appartenant à une entreprise industrielle. En raison de ce modèle, nous avons déterminé qu’une analyse séparée est nécessaire pour évaluer les implications de ces différences.

Purification du construit

Nous avons également déterminé la validité convergente et discriminante de chaque catégorie de l’instrument de mesure. Les valeurs de l’alpha de Cronbach ont été calculées pour chaque ensemble d’items « avantages stratégiques », « avantages transactionnels » et « utilité de l’information » de l’étude. Ces valeurs sont énumérées dans les tableaux 3 et 4. Aucun ajustement n’a pu être entrepris pour améliorer les alphas inférieurs à 0,7 concernant l’alignement stratégique, l’efficacité de la communication, l’objectivité et l’intelligibilité. Par conséquent ces items ont été retirés.

Tableau 3 – Convergence des items des avantages organisationnels

|

Catégorie |

Dimension | Nombre d’items |

α Cronbach |

| Avantages stratégiques | Alignement | 4 | 0.67 |

| Avantages stratégiques | Avantage compétitif | 3 | 0.77 |

| Avantages stratégiques | Relation client | 4 | 0.86 |

| Avantages transactionnels | Productivité de l’activité | 4 | 0.77 |

| Avantages transactionnels | Efficacité de la communication | 2 | 0.69 |

| Avantages transactionnels | Efficacité de développement du système | 3 | 0.74 |

Tableau 4 – Convergence des items Utilité de l’information

| Niveaux PSP/IQ | Dimension | Nombre d’items | α Cronbach |

| Utilité de l’information | Quantité | 4 | 0,77 |

| Interprétation | 4 | 0,77 | |

| Objectivité | 2 | 0,61 | |

| Pertinence | 3 | 0,80 | |

| Intelligibilité | 2 | 0,56 |

Le volume d’information n’améliore pas la qualité des décisions

L’analyse des données permet de mettre en évidence la relation entre l’utilité de l’information marketing et les avantages organisationnels. Ces analyses nous ont permis d’apporter une validation à l’hypothèse principale, ainsi qu’à plusieurs autres hypothèses construites a posteriori qui sont développées pour vérifier les différences systématiques découvertes au cours de l’examen des données concernant les secteurs d’activité.

- H1. Des améliorations dans l’utilité de l’information sont associées à des avantages stratégiques accrus.

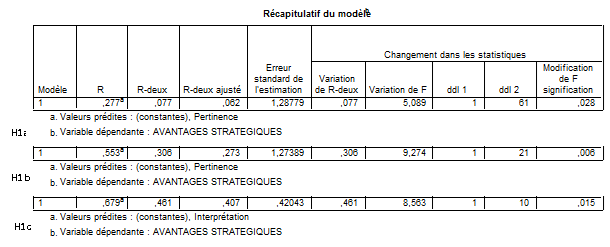

Les variables indépendantes associées à cette hypothèse sont la quantité, l’interprétation, et la pertinence. La variable dépendante, avantages stratégiques, représente la moyenne statistique des variables avantage concurrentiel et relation client. Parmi ces variables, seulement une seule présente des différences significatives entre les différents secteurs d’activité. Pour montrer ces différences, les trois hypothèses suivantes sont également évaluées :

- H1a. Des améliorations dans l’utilité de l’information sont associées à des avantages stratégiques accrus mesurés dans les activités de service.

- H1b. Des améliorations dans l’utilité de l’information sont associées à des avantages stratégiques accrus mesurés par les activités industrielles.

- H1c. Des améliorations dans l’utilité de l’information sont associées à des avantages stratégiques accrus mesurés dans les autres activités.

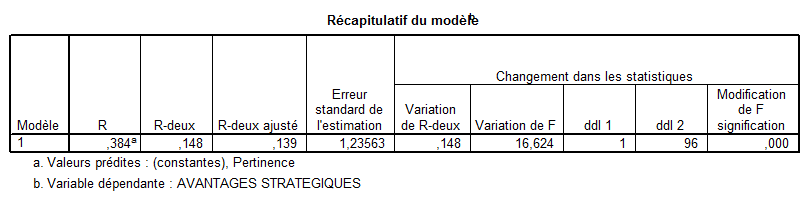

Pour évaluer H1, une analyse de régression multiple est menée pour déterminer quelles sont les variables indépendantes (quantité, interprétation et pertinence) qui expliquent la variable avantages stratégiques. Un résumé du modèle de régression est exposé dans le tableau 5. Les résultats de la régression indiquent un modèle général avec une variable explicative pertinence qui explique de manière significative les avantages stratégiques, R2 = 0,148, R2 ajustement = 0,139, F(1,96) = 16,624, p <0,001. Pour évaluer H1a, H1b et H1c, une analyse de régression multiple est effectuée pour déterminer lesquelles des variables indépendantes (quantité, interprétation et pertinence) expliquent les avantages stratégiques mesurés respectivement dans les activités de services, dans les activités industrielles et dans les autres activités. Les résumés des modèles de régression sont exposés dans le tableau 6. Les résultats de la régression indiquent un modèle général avec une variable explicative pour chacun des secteurs. La variable pertinence explique de manière significative les avantages stratégiques dans les activités de service, ainsi que dans le secteur de l’industrie. La variable interprétation explique de manière significative les avantages stratégiques dans les autres secteurs. Seule, la variable quantité n’explique pas une amélioration des avantages stratégiques.

Tableau 5 – Résumé du modèle pour H1

Tableau 6 – Résumé des modèles pour H1a, H1b, H1c

Nous avons procédé à un traitement et une analyse similaires concernant la relation entre l’utilité de l’information et les avantages transactionnels traduits par H2.

Les variables indépendantes associées à cette hypothèse sont la quantité, l’interprétation et la pertinence. La variable dépendante, avantages transactionnels, représente la moyenne statistique des variables productivité de l’activité et efficacité de développement des systèmes. Parmi ces variables, deux d’entre elles présentent des différences significatives entre les différents secteurs d’activité, par conséquent les trois hypothèses suivantes ont été également évaluées :

- H2a. Des améliorations dans l’utilité de l’information sont associées à une augmentation des avantages transactionnels mesurée dans les activités de services.

- H2b. Des améliorations dans l’utilité de l’information sont associées à une augmentation des avantages transactionnels mesurée dans les activités industrielles.

- H2c. Des améliorations dans l’utilité de l’information sont associées à une augmentation des avantages transactionnels mesurée dans les autres activités.

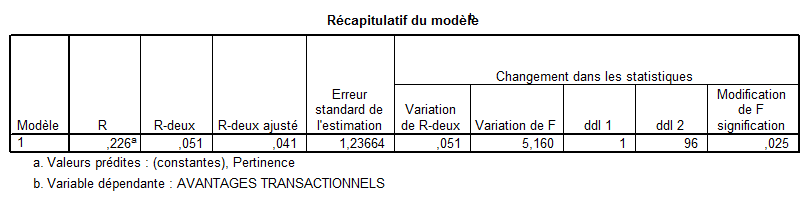

Concernant H2, les statistiques descriptives pour ces variables, un résumé du modèle de régression et les coefficients de corrélation à deux variables et partiels entre la variable explicative et la variable dépendante sont exposées dans le tableau 7. Ce modèle pour lequel nous observons une tolérance de 1.00, indique la pertinence comme variable explicative significative des avantages transactionnels, R2 = 0,051, R2 ajustement = 0,041, F(1,96) = 5,16, p =0,025.

Tableau 7 – Résumé du modèle pour H2

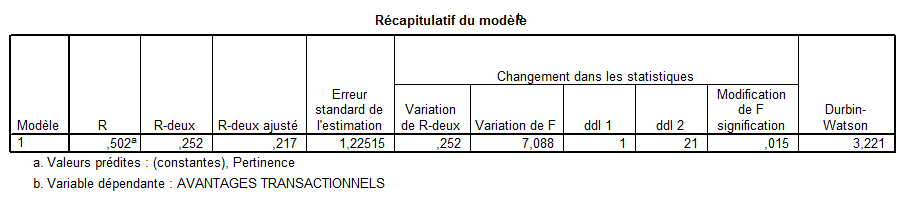

Concernant l’évaluation de H2a, H2b et H2c. Seule H2b présente une relation significative entre les variables. Le résumé des modèles de régression entre les variables explicatives et les variables dépendantes sont exposés dans le tableau 8. Les résultats de la régression indiquent un modèle général avec une variable explicative pour le secteur de l’industrie. La variable pertinence explique de manière significative les avantages transactionnels dans le secteur de l’industrie. A nouveau, la variable quantité n’explique pas une amélioration des avantages transactionnels.

Tableau 8 – Résumé du modèle pour H2b

Les analyses ci-dessus nous permettent de soutenir les hypothèses initiales, ainsi que quatre hypothèses supplémentaires proposées pour évaluer des différences résultant des dissimilitudes dans les secteurs d’activité. Le tableau 9 fournit un récapitulatif du soutien pour ces hypothèses. Le tableau 10 fournit un résumé de ces variables explicatives et de leurs relations significatives. La variable quantité n’est donc pas un facteur d’amélioration des résultats organisationnels.

Tableau 9 – Résumé du soutien des hypothèses principales

|

Hypothèse générale |

Services | Industrie | Autres secteurs | |

| H1 | Oui*** | Oui* | Oui** | Oui* |

| H2 | Oui* | Non | Oui* | Non |

* p < .05, ** p < .01, *** p < .001

Tableau 10 – Résumé des variables explicatives

| Variable explicative | Variable dépendante | Hypothèses (β) |

| Utilité | ||

| Quantité | Aucune | |

| Interprétation | Avantages stratégiques | H1c (0,68) |

| Pertinence | Avantages stratégiques Avantages transactionnels |

H1 (0,38), H1a (0,28), H1b (0,55) H2 (0,226), H2b (0,502) |

Développer de nouvelles compétences pour améliorer la qualité des décisions

L’analyse des données a permis d’apporter une preuve empirique quant à la validité du modèle proposé. Cependant la variable quantité n’est pas déterminée comme une variable significative dans l’amélioration des résultats organisationnels. Cette étude remet en cause le critère quantité de l’information largement utilisé dans la dimension « Utilité » du modèle sur la performance des produits et des services pour la qualité de l’information (Lee et al, 2002 ; Kahn et al., 2002). Le construit multidimensionnel de la qualité des données (Wang et Strong, 1996) paraît approprié dans le cadre d’une mesure de l’impact de l’utilité des données sur les avantages organisationnels si la variable quantité en est exclue. Le critère quantité de l’information est défini dans le modèle comme le degré selon lequel le volume des données est approprié. Les acteurs des entreprises de notre étude ne perçoivent pas ce critère comme utile à une meilleure qualité dans la prise de décisions stratégiques et opérationnelles. La portée de cette assertion est originale au regard de la concentration que portent les directions marketing à la connaissance du client à travers la multiplication de sources de recueil de données. Ce résultat appuie le constat qu’il n’y a pas de remise en cause de cette accumulation de données sur les clients qui trouve pour seule limite les systèmes technologiques et bases de données dont dispose l’entreprise. Inexorablement, les difficultés liées à l’utilisation et à la mesure de l’utilité de l’abondance informationnelle permettent d’envisager de nouvelles pistes de réflexion. La quantité de données rassemblées n’étant pas perçue comme impactant les résultats de l’organisation, une réflexion sur des systèmes ne permettant de collecter que des données utiles pour limiter l’abondance des informations à traiter n’est que peu envisagée par la fonction marketing. Les décideurs marketing doivent s’interroger sur la manière dont les systèmes transforment une masse de données en informations et doivent mener la réflexion sur l’intérêt de disposer d’autant d’informations si celles-ci ne peuvent être toutes traitées. Si l’explosion d’informations stratégiques disponibles étroitement liée aux possibilités offertes par des systèmes toujours plus performants en termes de capacités de stockage n’impacte pas les résultats de l’entreprise à travers la prise de décisions, quelles sont alors les qualités et compétences requises des managers pour émettre les meilleures décisions quelle que soit la quantité d’informations disponibles ?

Favoriser la réflexion sur la pertinence et l’interprétation des informations

Les critères validés par le modèle sont l’interprétation et la pertinence au détriment de la quantité d’information.

Le critère interprétation de l’information est défini dans le modèle de Wang et Strong (1996) comme le degré selon lequel les données sont présentées dans la bonne langue, avec la bonne unité de mesure et la bonne définition (nous retrouvons ici les termes de visualisation et de véracité utilisés pour définir la notion de big data). La pertinence est définie comme le degré selon lequel les données permettent d’aider à la réalisation de la tâche (valeur et vélocité). L’utilisation d’informations pertinentes et interprétables (valeur/véracité) est alors bien plus utile à la prise de décisions que la quantité (volume). Nous constatons alors que la liste élargie des « V » pour définir les big data recense des variables déjà utilisées dans les modèles d’évaluation de la qualité des données dans les systèmes d’information. Cependant, il est demandé aux décideurs marketing de gérer toujours plus d’informations dans la mise en place d’actions marketing. Les acteurs du marketing ne sont pas considérés comme les plus adéquats pour gérer la surabondance d’informations (McAfee et Brynjolfsson, 2012), quelle que soit la quantité d’informations disponibles, les décisions n’en sont pas affectées. Cette focalisation sur les quantités de données disponibles masque toute notion de pertinence, d’interprétation et de qualité de l’information. Elle minimise également toute notion d’impact sur la qualité des décisions prises. D’ailleurs McAfee et Brynjolfsson (2012) expriment cette aberration en expliquant que lorsque le manager est face à la rareté de l’information, les décisions laissent une part importante à l’intuition, laquelle intuition demeure l’essence même des qualités d’un bon manager. Face à l’abondance d’informations, l’entreprise doit gérer la rareté et ainsi intégrer les seules informations utiles à l’aide de systèmes d’informations toujours plus performants pour délivrer aux décideurs marketing des informations intelligibles et pertinentes.

Conclusion

En nous appuyant sur la typologie de Wang et Strong (1996), nous avons opérationnalisé une échelle de mesure de la qualité de l’information et nous avons retenu la dimension « Utilité de l’information » qui comprend trois variables : la quantité, l’interprétation et la pertinence des données. Même si l’utilisation d’un cadre théorique ancien mais qui a fait ses preuves dans le management de la qualité des données peut être contesté, nos résultats montrent que l’amélioration de « l’utilité de l’information » pour le système d’information marketing est perçue comme un facteur d’influence sur les avantages stratégiques et transactionnels de l’organisation. Les résultats montrent cependant que la variable « quantité » de l’information n’a aucune incidence sur cette relation bien que l’attention portée à l’amélioration de l’utilité de l’information soit identifiée comme une variable explicative significative de meilleurs résultats dans l’organisation par le biais de la prise de meilleures décisions. Ces résultats remettent en cause l’état actuel des systèmes d’information marketing et la focalisation sur la nécessité d’accumuler toujours plus de données. Si l’interprétation et la pertinence sont des facteurs explicatifs de meilleures décisions, la quantité ne l’est pas. Les décideurs marketing se retrouvent donc face au nouveau défi de l’immédiateté qui occulte certainement le sens et le temps de la réflexion sur le long terme et par conséquent les questions fondamentales de l’interprétation et de la pertinence des informations traitées dans l’immédiateté. L’évolution de la fonction marketing à l’ère du big data requiert des compétences qui vont au-delà de l’utilisation de l’information. La Science du Data Marketing basée sur l’utilité de l’information implique la maîtrise de compétences plus techniques (implémentation d’outils d’aide à la gestion). Les métiers du marketing, bien que bouleversés prendront tout leur sens à l’ère de l’automatisation car outre le rôle de connecteur entre différents métiers (statisticiens, ingénieurs, informaticiens), ils développeront la méfiance du business comme une arme stratégique. La quantité d’informations devenant alors un phénomène maîtrisable, il s’agira alors de se concentrer sur la qualité des données et de l’information à analyser. Les modèles d’analyse de la qualité des données dans les systèmes d’information (qui auront certes évolués) revêtiront alors d’un intérêt certain au fur et à mesure que la liste des « V » pour conceptualiser le phénomène Big data s’élargira pour se rapprocher de construits multidimensionnels déjà existants.

Bibliographie

Barton, D. et Court, D. (2012). Making advanced analytics work for you – A practical guide to capitalizing on Big data. Harvard Business Review, October, 90(10), 79-83. Repéré à https://hbr.org/2012/10/making-advanced-analytics-work-for-you

Chintagunta, P., Dominique M. H. et John R. H. (2016). Marketing Science and Big data. Marketing Science, 32 (1), 4–7. doi: 10.1287/mksc.2016.0996

Gallagher, C. A. (1974). Perceptions of the value of a management information system. Academy of Management Journal, 17(1), 46-55. doi: 10.2307/254770

Halloran, D., Manchester, S., Moriarty, J., Riley, R., Rohrman, J., Skramstad, T. (1978). Systems development quality control. MIS Quarterly, 2(4), 1-13. Repéré à https://misq.org/catalog/product/view/id/97

Hartono, E., Li, X., Na, K-S, Simpson, J.T. (2010). The Role of the Quality of shared information in Interorganizational systems use. International Journal of Information Management, 3(5), 399-407. doi : 10.1016/j.ijinfomgt.2010.02.007

Hofacker, C. F., Malthouse, E. C. et Sultan F., (2016). Big data and Consumer Behavior: Imminent Opportunities. Journal of Consumer Marketing, 33 (2), 89–97. doi: 10.1108/JCM-04-2015-1399

Kahn, B. K., Strong, D. M. et Wang, R. Y. (2002). Information quality benchmarks: Product and service performance. Communications of the ACM, 45(4), 184-192. Repéré à http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.5.4752&rep=rep1&type=pdf

Lee, Y. W., Strong, D. M., Kahn, B. K. et Wang, R. Y. (2002). AIMQ: A methodology for information quality assessment. Information and Management, 40(2), 133-146. Repéré à http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.6.2407&rep=rep1&type=pdf

Mirani, R. et Lederer, A. L. (1998). An instrument for assessing the organizational benefits of IS projects. Decision Sciences, 29(4), 803-838. doi: 10.1111/j.1540-5915.1998.tb00878.x

McAfee, A. et Brynjolfsson, E., (2012). Big data: The Management Revolution. Harvard Business Review, October, 90(10), 60-68. Repéré à https://hbr.org/2012/10/big-data-the-management-revolution

Sivarajah, U., Kamal, M. M., Irani, Z. et Weerakkody, V., Weerakkody (2017). Critical Analysis of Big data Challenges and Analytical Methods. Journal of Business Research, 70, 263–86. doi:10.1016/j.jbusres.2016.08.001

Skiera, B. (2016). Data, Data, and Even More Data: Harvesting Insights from the Data Jungle. GfK Marketing Intelligence Review, 8 (2), 10–17. doi:10.1515/gfkmir-2016-0010

Wang, R. Y., Storey, V. C., Firth, C. P. (1995). A framework for analysis of data quality research. IEEE Transactions on Knowledge and Data Engineering, 7(4), 623-640. doi: 10.1109/69.404034

Wang R.Y., Strong D.M. (1996). Beyond Accuracy: What Data Quality Means to Data Consumers. Journal of Management Information Systems, 12(4), 5-33. doi: 10.1080/07421222.1996.11518099